In dieser Aufzeichnung stellen wir Ihnen Verbesserungen und Neuerungen der Version 6.3 von ![]() GeNiEnd2End vor.

GeNiEnd2End vor.

Dies sind einige davon:

- Verbessertes Notification System und Filtermöglichkeiten

- Möglichkeiten neuer inkludierter Skripte

- VoIP-Tests für Microsoft Teams & Skype

- Effizienteres Updaten der GeNiJacks durch Nutzungen des neuen Update Hubs

- Realisierung und Auswirkungen der verbesserten Performance

- Details der Sicherheitsupdates

- Kombination von Allegro Packets Network Multimeter und NETCOR GeNiEnd2End

Sollten Sie dazu Fragen haben, eine neue Lizenzdatei oder Unterstützung bei dem Update benötigen, melden Sie sich gerne bei uns:

+49 4181 9092-110

support@netcor.de

Grundsätzlich sind zahlreiche Cybergefahren ebenso bekannt wie verwendete Tools und das Vorgehen von Hackern, mit dem sie Netze infiltrieren, Clients infizieren und Daten verschlüsseln. Damit ein Angriff auf die eigene Infrastruktur allerdings auch „rechtzeitig“ erkannt und anschließend erfolgreich abgewehrt werden kann, benötigt man ein darauf spezialisiertes Werkzeug der Gattung Network Detection and Response.

Wir zeigen Ihnen in diesem Webinar, wie ExeonTrace mit Hilfe von Machine Learning und Kl zuverlässig Cybergefahren erkennt. Diese Zuverlässigkeit beinhaltet auch, dass ExeonTrace False Positives deutlich reduziert und damit das Security-Team nicht unnötig belastet.

Ein NDR kann und soll EDR nicht ersetzen. Wir erläutern, wie Sie EDR, NDR und SIEM sinnvoll miteinander kombinieren. Zusätzlich geht es darum, wie sich ExeonTrace in die komplette Infrastruktur, also auch in Legacy Systeme, integrieren lässt.

Wenn Sie ExeonTrace näher kennenlernen wollen, melden Sie sich bitte telefonisch oder über das Kontaktformular bei uns.

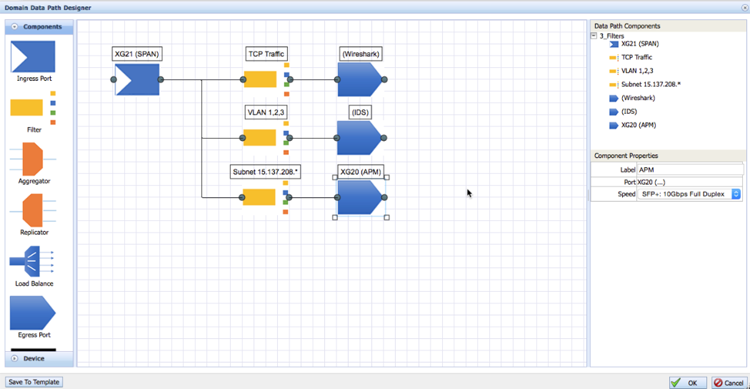

Geht es darum, bei Problemen mit der Anwendungsperformance oder zur Bewertung der Kommunikationen im Netzwerk eine Aussage zu treffen, werden Datenpakete analysiert. Auf Seiten der Security gibt es in Form von IDS oder NDR ebenfalls Tools, die auf Datenpakete angewiesen sind.

Der kürzeste Weg, diese Daten aus dem Netzwerk abzugreifen ist der SPAN-Port. Nachteil ist, dass SPAN-Ports nicht für den 24/7-Betrieb gedacht sind und auch weitere Schattenseiten aufweisen: Bei Performance-Analysen ist zu beachten, dass Pakete recht schnell verloren gehen können oder in falscher Reihenfolge eintreffen. Defekte Pakete werden gar vollständig unsichtbar, sie werden schlicht verworfen.

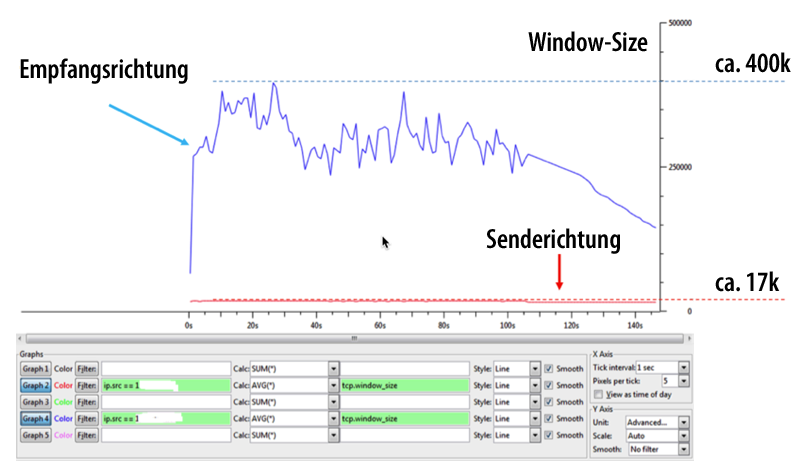

Aus Sicherheitssicht ist ein SPAN-Port ebenfalls keine optimale Idee, er stellt aufgrund des Vorhandenseins von Empfangs- aber auch Senderichtung ein Risiko dar.

Wir zeigen Ihnen in diesem Webinar detailliert, weshalb der Einsatz von TAPs oder auch Daten-Dioden vorteilhaft ist. Dabei gehen wir darauf ein, was für Arten von TAPs es gibt und wie sie im Zusammenspiel von TAPs und Network Packet Broker Switchen sehr effizient und flexibel viele Messpunkte einrichten können.

Die Datenpakete können sie anschließend aufbereiten, aggregieren und weiterleiten. In vielen Fällen lassen sich dadurch Kosten für Analysegeräte & Lizenzen reduzieren.

Für jeden Security-Verantwortlichen ist die gestiegene Professionalität, mit der sich Hacker durch Cyberattacken Zutritt in fremde Netze verschaffen wollen, zu einer großen Herausforderung geworden. Auch wenn die Basics wie Virenschutz, IDS/IPS und EDR-Lösungen, längst im Einsatz sind, insbesondere bei komplexen Angriffen sind sie nicht ausreichend.

Ein entscheidender Nachteil der vorgenannten Lösungen ist, dass ihre Stärke in der Erkennung von längst bekannten Angriffen liegt und für die es Erkennungssignaturen gibt. Bei gänzlich neuen Attacken sind sie regelmäßig wirkungslos. Zusätzlich lässt sich zum Beispiel auch nicht auf jedem Device ein EDR installieren.

Einen äußerst wirkungsvollen Ausweg aus diesem Sicherheits-Dilemma gegen bislang unbekannte Unbekannte stellt der Einsatz einer Network Detection and Response Lösung dar.

Grundlegende Annahme dieses Ansatzes ist, dass keine Cyber-Attacke auf die Nutzung des Netzwerks verzichten kann. Der vorhandene Netzwerkverkehr wird vom NDR protokolliert und anschließend analysiert.

Wie NDR in IT, IoT und OT implementiert wird und wie Sie damit zuverlässig Anomalien im Netzwerkverkehr und somit potentielle Sicherheitsvorfälle erkennen können, zeigen wir Ihnen in diesem Video.

Wenn Sie ExeonTrace näher kennenlernen wollen, melden Sie sich bitte telefonisch oder über das

Kontaktformular bei uns.

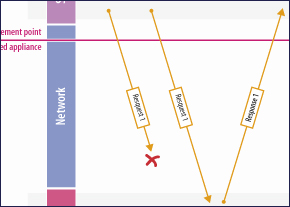

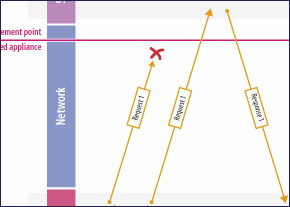

Das Konzept der automatischen Reaktion (Automatic Response) in Network Detection & Response (NDR) Lösungen zielt darauf ab, Cyberbedrohungen schnell und präzise abzuwehren, ohne auf menschliches Eingreifen angewiesen zu sein.

NDR-Systeme können automatische Reaktionsfunktionen einsetzen, wie beispielsweise das Versenden eines TCP-Resets an potenziell kompromittierte Systeme, um die Verbindung zu externen Bedrohungsquellen zu unterbrechen. Ebenso ist es möglich, kompromittierte Geräte in separaten Netzwerksegmenten zu isolieren.

Trotz der anfänglichen Begeisterung für solche Technologien gibt es nachvollziehbare Gründe, die gegen eine ausschließliche Automatisierung sprechen und die Bedeutung bewährter Prozesse mit manueller Intervention betonen:

- Herausforderungen bei der Integration: Die Integration des NDR-Systems mit heterogener Netzwerkinfrastruktur kann kompliziert sein. Veränderungen wie Updates, Patches oder Konfigurationsänderungen können unvorhergesehene Auswirkungen haben.

- Ausnahmeregelungen: Unerfasste oder undokumentierte Ausnahmen führen zu Inkonsistenzen. Dies birgt das Risiko, dass die automatische Reaktion nicht wie beabsichtigt funktioniert.

- Fehlalarme und Fehlfunktionen: Fehlerhafte automatische Reaktionen gefährden die Sicherheit und Effizienz. Automatische Isolierung kann den Geschäftsbetrieb beeinträchtigen, insbesondere bei kritischen Systemen.

- Compliance und rechtliche Aspekte: Automatische Reaktionen könnten Compliance verletzen, je nach Branche und Vorschriften.

Eine sorgfältige Planung, Konfiguration und Überwachung von automatischen Reaktionen in NDR ist unerlässlich, um potenzielle Nachteile zu minimieren. Die Herausforderung liegt oft in der durchschnittlichen Fehlalarmrate pro Tag. Solche Fehlinterpretationen von Ereignissen können zu unnötiger Isolierung von Geräten führen.

Um diese Risiken zu minimieren, ist es wichtig, dass automatische Response-Systeme sorgfältig konfiguriert und insbesondere bei Änderungen ausführlich getestet werden. Es sollten klare Richtlinien und Prozesse für die Überprüfung und Freigabe von Isolierungen im Falle eines Fehlalarms vorhanden sein.

Unter Berücksichtigung dieser Faktoren zeigt sich häufig, dass die Erweiterung bestehender Prozesse zur effizienten Bewältigung von Sicherheitsalarmen in Kombination mit fortschrittlichen NDR-Systemen, eine sinnvolle Alternative darstellt. Besonders, wenn die Umsetzung und der Betrieb automatischer Reaktionen als ressourcen- und zeitintensiv erscheinen.

In der abschließenden Episode unserer Reihe „Der Nutzen von Network Detection and Response in IT, IoT und OT“ geht es um Machine Learning in der Cyber-Security. Generell taucht KI und auch seine Teildisziplin ML im IT-Alltag regelmäßig auf. Der konkrete Mehrwert durch ML und wie er erreicht wird, bleibt dabei jedoch häufig unklar.

Wir zeigen Ihnen in diesem Webinar worin der Vorteil der Benutzung von ML liegt und wie sich supervised Machine Learning und unsupervised Machine Learning in Funktionsweise und Nutzen unterschieden.

Zusätzlich stecken wir mit Ihnen ab, bei welchen unterschiedlichen Bedrohungen Machine Learning und Signaturen/IoC die jeweiligen Stärken ausspielen können.

Wenn Sie ExeonTrace näher kennenlernen wollen, melden Sie sich bitte telefonisch oder über das Kontaktformular bei uns.

Im dritten Teil unserer Reihe „Der Nutzen von Network Detection and Response in IT, IoT und OT“ geht es insbesondere um die Besonderheiten der Security im OT-Umfeld.

Anhand einer Beispielarchitektur zeigen wir Ihnen, welche Bedrohungen es konkret gibt und wodurch diese begünstigt werden. In dem Zusammenhang gehen wir natürlich auch auf die Purdue Reference Architecture ein.

In einem Szenario gehen wir zusammen durch, zu welchen Zeitpunkten ExeonTrace eine Bedrohung detektiert. Da leider auch Network Detection and Response keine Eierlegende Wollmilchsau ist, zeigen wir auf, wo ein NDR prinzipbedingt in der Erkennung Grenzen hat.

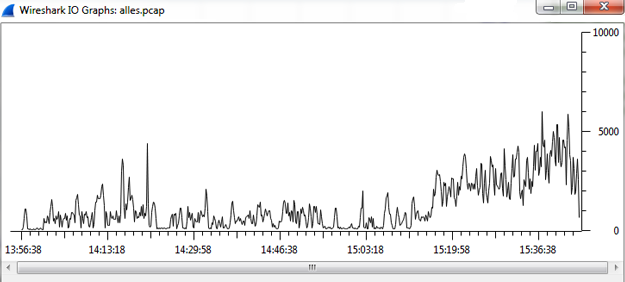

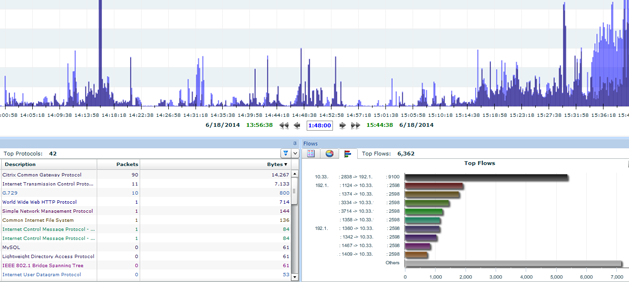

Im finalen Teil unserer Reihe „Datenpakete effizient analysieren“ ist Wireshark mit den Erkenntnissen der vorherigen Episoden richtig konfiguriert und der Datenverkehr wird mittels TAPs und ggf. NPBS passend eingesammelt, vorgefiltert und weitergeleitet. Somit sind alle Vorbereitungen getroffen, um über die benötigte Transparenz zu verfügen.

Wir zeigen Ihnen, wie Sie selbst mit richtig vielen Daten über eine mächtige Suche sehr, sehr schnell im Troubleshooting Fall den Fokus auf die relevanten Pakete legen können. Zum Ausschließen von Segmenten und damit Eingrenzen von Problem-verursachenden Segmenten ist eine Strecken-/Zangenmessung mit mehreren Messpunkten sehr effizient. Am Live System vom Allegro Network Multimeter gehen wir mit Ihnen durch, wie Sie ausgesprochen unkompliziert zwei Tracefiles gegeneinander abgleichen können.

Vom Allegro Network Multimeters können natürlich auch externe Tracefiles, die zum Beispiel mit

Wireshark oder einem

EtherScope erstellt wurden, analysiert werden.

Der fünfte Teil unserer Reihe „Datenpakete effizient analysieren“ widmet sich einem Security-Thema. Es geht darum, wie man Datenpakete aus kritischen Netzen sicher an IDS und NDR weiterleiten kann.

Naheliegend ist dabei für viele die Benutzung eines vorhandenen Span-Ports. Wir zeigen, wieso das insbesondere KRITIS-Betreiber unterlassen sollten. Dabei geht es um die technische Unsicherheit aber auch um die "Chance", über einen Span-Port nicht alle Pakete für Analysezwecke zu erhalten.

Damit das Webinar auch einen konstruktiven Charakter erhält, stellen wir Ihnen mit Daten-Dioden, Taps und Network Packet Broker Switches Alternativen vor, die aus Sicherheits- und Funktionssicht deutlich besser sind.

In der vierten Episode unserer Reihe „Datenpakete effizient analysieren“ geht es um die Möglichkeiten, mehrere Messpunkte mit Aggregation TAPs oder Network Packet Broker Switches effizient zu nutzen. Dabei stellen wir Ihnen vor, welche Optionen Ihnen bei der Verteilung der Daten auf mehrere Analysetools für Performance und Security zur Verfügung stehen.

Wir gehen auch darauf eine, worauf man bei Duplicate Packets mit einem Network Packet Broker Switch achten muss und wie man Packet Deduplication mit Wireshark und weiteren Analysetools handhabt.

Im zweiten Teil unserer Reihe „Der Nutzen von Network Detection and Response in IT, IoT und OT“ stellen wir Ihnen das typische Vorgehen eines Angreifers anhand der Cyber Kill-Chain vor.

Dabei gehen wir auch darauf ein, welche Netzwerkdaten einen Angreifer in der jeweiligen Phase verraten.

Wichtig ist dabei zu wissen, dass die einzelnen Schritte für sich genommen so unauffällig sind, dass sie ohne ein NDR wie Exeon Trace nicht erkannt werden würden.

Abgerundet wird das Webinar mir einer Live-Demo, in der gezeigt wird, wie ein Cyber-Angriff konkret erkannt wird.

Der dritte Teil unserer Reihe „Datenpakete effizient analysieren“ beschäftigt sich mit der Frage, wie Messdaten zuverlässig in einen Analyzer gelangen. So banal die Aufgabenstellung klingen mag - geschieht hier ein Fehler im Messaufbau, sind meist alle weiteren Analyseschritte wertlos.

Mit diesem Wissen im Hinterkopf beleuchten wir den im ersten Gedankengang plausibelsten Weg der Datenausleitung: Den Span-Port. Dabei erläutern wir, wenn denn im jeweiligen Fall möglich, wie man den Span-Port richtig benutzt.

Die aus technischer Sicht schönste Lösung stellen für Kupfer und Glas verfügbare TAPs dar. Diese zeigen wir Ihnen ausführlich.

Abgerundet wird das Webinar mit einer detaillierten Definition von Last und den Möglichkeiten, sie falsch zu interpretieren. Hier spielen Microbursts eine große Rolle.

Bei dem Auftakt unserer Reihe „Der Nutzen von Network Detection and Response in IT, IoT und OT“ zeigen wir Ihnen, wie Network Detection and Response einen Baustein der Security-Architektur eines Unternehmens darstellt.

Dabei gehen wir darauf ein, wie mit Hilfe von Kommunikationsanalysen Angriffe in IT, IoT sowie OT automatisch erkannt und dann auch schnell analysiert werden können.

Ein wichtiger Punkt ist dabei das Thema Machine Learning. Auch wenn ML mittlerweile ein arg gestresster Begriff ist: In Exeon Trace ist ML integriert und hilft effizient bei der Erkennung von Anomalien und der Reduzierung von False Positive Alarmen.

Thema des zweiten Teils unserer Reihe „Datenpakete effizient analysieren“ ist das mobile Troubleshooting ohne Kompromisse.

Am Anfang einer jeden Paketanalyse steht das Capturen von Paketen. In dem Webinar gehen wir darauf ein, wieso in vielen Fällen PC, Laptop und auch ein SPAN-Port für eine fehlerfreie Aufzeichnung von Datenpaketen nicht geeignet ist.

Anhand von ProfiShark,

IOTA und

Allegro Network Multimeter zeigen wir Ihnen, wie Sie im IT- und OT-Umfeld effizient capturen, filtern und analysieren können.

Für den Fall, dass Sie gerne Ihre Wireshark-Kenntnisse ausbauen wollen, bieten wir Ihnen dazu eine Schulung an.

Im ersten Teil unserer Troubleshooting-Reihe „Datenpakete effizient analysieren“ geht es darum, wie und wann man Wireshark einsetzen sollte, um mit vertretbarem Aufwand ein Problem analysieren zu können.

Dabei zeigen wir Ihnen auch, wie ein Messaufbau für eine zuverlässige Messung im Optimalfall aussieht und welche Einstellungen in Wireshark vorgenommen werden müssen, um überhaupt sinnvoll Daten damit aufzeichnen zu können.

Für den Fall, dass Sie gerne Ihre Wireshark-Kenntnisse ausbauen wollen, bieten wir Ihnen dazu eine Schulung an.

Wireshark 4 hat einige Detailverbesserungen erhalten. Dazu gehören zum Beispiel umfangreichere Filtermöglichkeiten sowie verbesserte Konversationsstatistiken. Anhand von Praxisbeispielen zeigen wir Ihnen, wann und wie Ihnen diese Verbesserungen das Arbeiten mit Wireshark vereinfachen.

Zusätzlich gehen wir auf Änderungen der Benutzeroberfläche ein und wie dadurch der Workflow verbessert werden kann.

Falls Sie Wireshark-Kenntnisse aufbauen oder verbessern wollen, können Sie gerne für eine Schulung auf uns zu kommen.

Die Übertragung von Sprache über das IP-Protokoll birgt sowohl in Unternehmensnetzen als auch im Providerumfeld diverse Herausforderungen. So gibt es zunächst eine sehr hohe Verfügbarkeitsanforderung. Als Echtzeitdienst bemerken die Nutzenden aber auch sofort Probleme in der Dienstgüte. Gerade die Netzwerkqualitätsparameter Paketverlust, Jitter und Delay haben einen großen Einfluss auf die resultierende Sprachqualität.

Grundsätzlich ist im VoIP-Umfeld zu beachten, dass man zwischen drei Datenströmen differenziert, wobei nur zwei einen bemerkbaren Einfluss für die Nutzenden hat.

- Den ersten Datenstrom stellt die Signalisierung dar. Als Signalisierung bezeichnet man die Kommunikation zum Auf- und Abbau, sowie Änderungen. Dabei werden auch schützenswerte Metadaten, wie Quell- und Zielrufnummer übertragen. Es gibt unterschiedliche Protokolle zur Signalisierung, wie SIP (Session Initiation Protocol), H.323 oder MGCP (Media Gateway Control Protocol). Im öffentlichen Netz und aktuellen Unternehmensnetzen kommt primär das SIP-Protokoll zum Einsatz. Es gibt jedoch eine Vielzahl von unterschiedlichen SIP-Implementierungen. Dies führt in der Praxis zu vielfältigen Fehlerquellen durch Inkompatibilitäten. Im Payload der Signalisierung, genauer gesagt im Session Description Protocol (SDP) werden aber auch einige Parameter, wie zu verwendende Codecs und die UDP-Ports, sowie die zugehörigen IP-Adressen für die Sprachdatenübertragung ausgehandelt.

- Den zweiten Datenstrom stellt die Übertragung der Sprache über das Real-Time Transport Protocol (RTP) dar. Dieses Protokoll basiert auf einer UDP-Übertragung und es ist als Echtzeitübertragung besonders sensitiv gegenüber Latenz, Jitter und Paketverlusten. Es können Hierbei unterschiedliche Codecs mit unterschiedlichen Paketierungszeiten, Größe und Qualität zum Einsatz kommen.

- Den dritten Datenstrom stellt das Real-Time Transport Control Protocol (RTCP) dar. Er liefert statistische Daten mit Qualitätsindikatoren für VoIP. Dieser Datenstrom fließt auf gleichem Transportweg wie RTP, jedoch eine Portnummer höher.

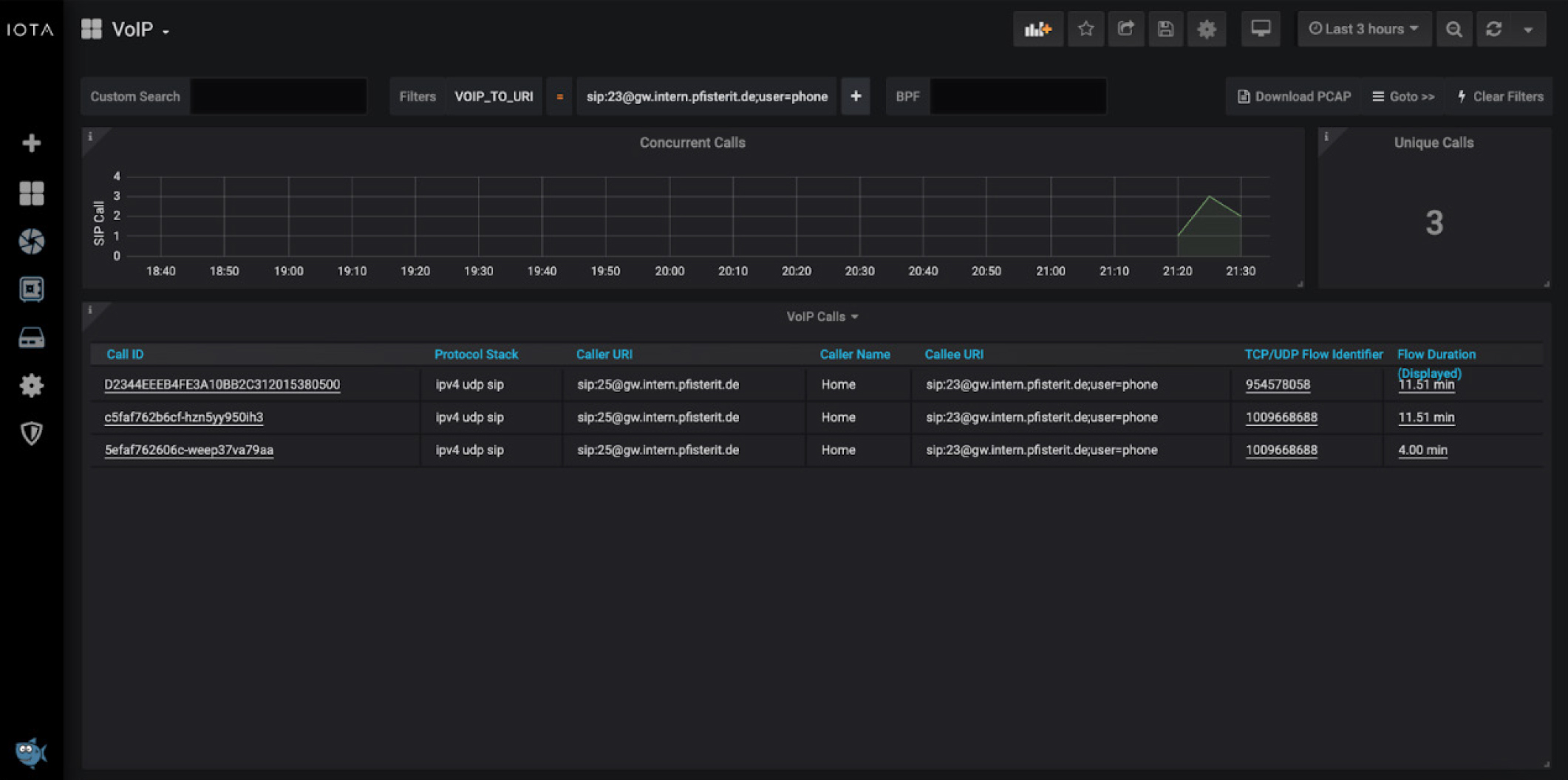

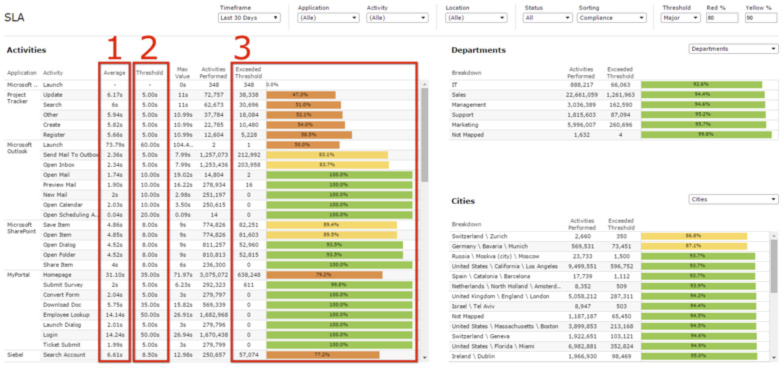

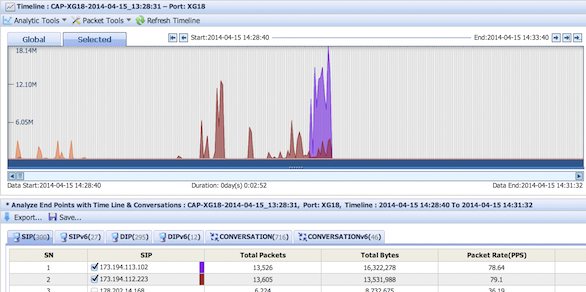

Eine große Herausforderung beim Troubleshooting in VoIP-Umgebungen stellt die Differenzierung der Fehlerursache zwischen Signalisierung und Sprachdaten oder auch dem zugrunde liegenden Netzwerk dar. Die unterschiedlichen Medienströme müssen in vielen Fällen auch NAT-Übergänge oder auch Sicherheitskomponenten, wie Firewalls passieren. Dies führt in der Praxis dazu, dass sich die zuständigen Teams für VoIP, Netzwerk und Sicherheit bei Fehlern die zugehörigen Tickets hin- und herschieben. Das Profitap IOTA hat es sich zur Aufgabe gemacht, die VoIP-Analyse effektiv und effizient zu machen. Das „Blame Game“ zwischen den unterschiedlichen Teams soll durch grafisch aufbereitete Dashboards in Kombination mit vielfältigen Filteroptionen für SIP und RTP ein Ende haben und für den Endanwender die Mean-Time-to-Recover (MTTR) durch eine schnelle Fehleranalyse verkürzen. Dienstanbieter können somit auch Ihre SLAs besser einhalten.

Root Cause Analyse

Die Root Cause Analyse in VoIP Netzen gleicht häufig der Suche nach der Nadel im Heuhaufen. Von den Anwendern kommen meist recht unstrukturierte Fehlermeldung, wie „Mein Telefon funktioniert seit gestern nicht mehr. Ich erhalte immer ein Besetzt-Zeichen.“ oder „Ich habe zeitweise Verständigungsprobleme mitten im Gespräch.“. Ob dies am Netzwerk, einer Firewall, einem Signalisierungsfehler auf einem SIP-Proxy oder einem Fehler der Endgeräte liegt, kann zunächst nur schwierig differenziert werden. Aber auch einseitige oder gar keine Verständigung (One Way Audio oder Dead Air Effekt), sowie zeitweise abbrechende Anrufe stellen eine Herausforderung im Troubleshooting Prozess dar.

Es gilt also die grundsätzliche Ursache des Problems (Root Cause) zu ermitteln. Wenn die Key Performance Indikatoren Paketverlust, Jitter und Delay bidirektional ohne Auffälligkeiten sind, kann ein Sicherheits- und Netzwerkproblem ausgeschlossen werden. Die Ursache kann dann direkt im VoIP-Umfeld gesucht werden. Jedoch ist nicht jede VoIP-Verbindung direkt Ende-zu-Ende messbar. Sogenannte Session Border Controller (SBC) können an Sicherheitsübergängen den SIP-Dialog und den RTP-Datenstrom je Kommunikationsseite terminieren und manipulieren. Es kann also geschehen, dass trotz gemessenen Paketverlusten von 0% bis zum Provider hinter dessen SBC ein Paketverlust zu einem anderen Provider besteht. Somit sind VoIP Analysen auch häufig an multiplen Punkten im Netzwerk durchzuführen.

Im VoIP-Umfeld selbst muss zunächst definiert werden, ob es sich um ein Problem in der Signalisierung oder im Sprachdatenstrom handelt. Kommt es beim Verbindungsauf- oder Abbau oder einer Veränderung, wie einem Halten des Gesprächs oder einem Codecwechsel zu Problemen, liegt dies an einem Signalisierungsproblem und es kann gezielt in den SIP-Daten über Filter eine Eingrenzung

geschehen.

Schwieriger in der Analyse sind die bereits erwähnten Fehlerbilder, wie Dead Air und One Way Audio. Diese können sowohl aus dem Netzwerk kommen, aber auch durch Firewalls und IPS-Systeme oder Probleme in Baugruppen des VoIP-Systems. Beispiel für einen Netzwerkfehler wäre ein fehlerhaftes Routing oder ein NAT-Übergang. Problem bei NAT im Zusammenhang mit VoIP ist, dass lediglich die IP-Informationen im Header ersetzt werden, jedoch nicht im Payload. SIP überträgt jedoch im Session Description Protocol (SDP) IP- und Portinformationen für den RTP-Stream. Wenn nun ein NAT-Übergang die IP-Header manipuliert, aber im Payload keine Anpassung vollzogen wird, führt dies zu einseitiger oder keiner Verständigung, da der RTP-Datenstrom zum falschen Ziel geführt wird. Gleichzeitig besteht aber auch die Möglichkeit, dass eine Firewall die Ports für die Signalisierung zulässt, aber den RTP-Datenstrom blockt. Aber auch Intrusion Prevention System bieten eine mögliche Fehlerquelle für geblockte RTP-Datenströme. Gleichzeitig könnte dies jedoch auch im VoIP-Umfeld an einer nur einseitigen Verschlüsselung mit SRTP oder einem fehlerhaften Codecwechsel oder defekten VoIP-Baugruppen, wie DSPs liegen. Es braucht also für die Root Cause Analyse ein Werkzeug, dass flexibel an unterschiedlichen Stellen im Netzwerk zum Einsatz kommen kann und mit einfachen Mitteln einen „Drill Down“ auf die benötigten Informationen ermöglicht.

Wie kann Profitap IOTA unterstützen?

Das Profitap IOTA bietet eine portable Lösung zur VoIP Analyse. Damit eignet es sich, um an unterschiedlichen Stellen im Netzwerk aufzuzeichnen und zu analysieren. Sowohl der Betrieb im Inline-, als auch im SPAN-Modus sind möglich. Somit ist es in der VoIP Analyse flexibel einsetzbar, da es sowohl zwischen Telefon und Switch im Inline Betrieb geschaltet werden kann, aber auch direkt an einem SPAN-Port des Switches, wenn beispielsweise ganze VLANs oder ein Switchport zu einem Session Border Controller oder einer IP-PBX analysiert werden müssen.

Neben der reinen Aufzeichnung bietet das IOTA jedoch auch applikationsseitige Analysefunktionen für VoIP. Somit kann dem Fingerpointing zwischen Netzwerk- und Voice-Team schnell ein Ende gesetzt werden. Netzwerkadministratoren können für definierte Zeiträume oder sogar einen spezifischen Anruf Paketverluste und Jitter erkennen. Dies kann über eine Filterung auf die Quell- oder Ziel-URI des Anrufers geschehen. Abbildung 2 bietet ein Beispiel eines Filters auf die Ziel-URI. Übergibt der VoIP-Administrator sogar die Call-ID des Anrufs, kann direkt eine Filterung auf den Anruf stattfinden. So kann der Fehler soweit vorqualifiziert werden, dass im Nachgang gezielt auf einzelnen Netzwerkkomponenten, wie Switches und Routern auf Link-Fehler und Quality of Service Probleme gesucht werden kann.

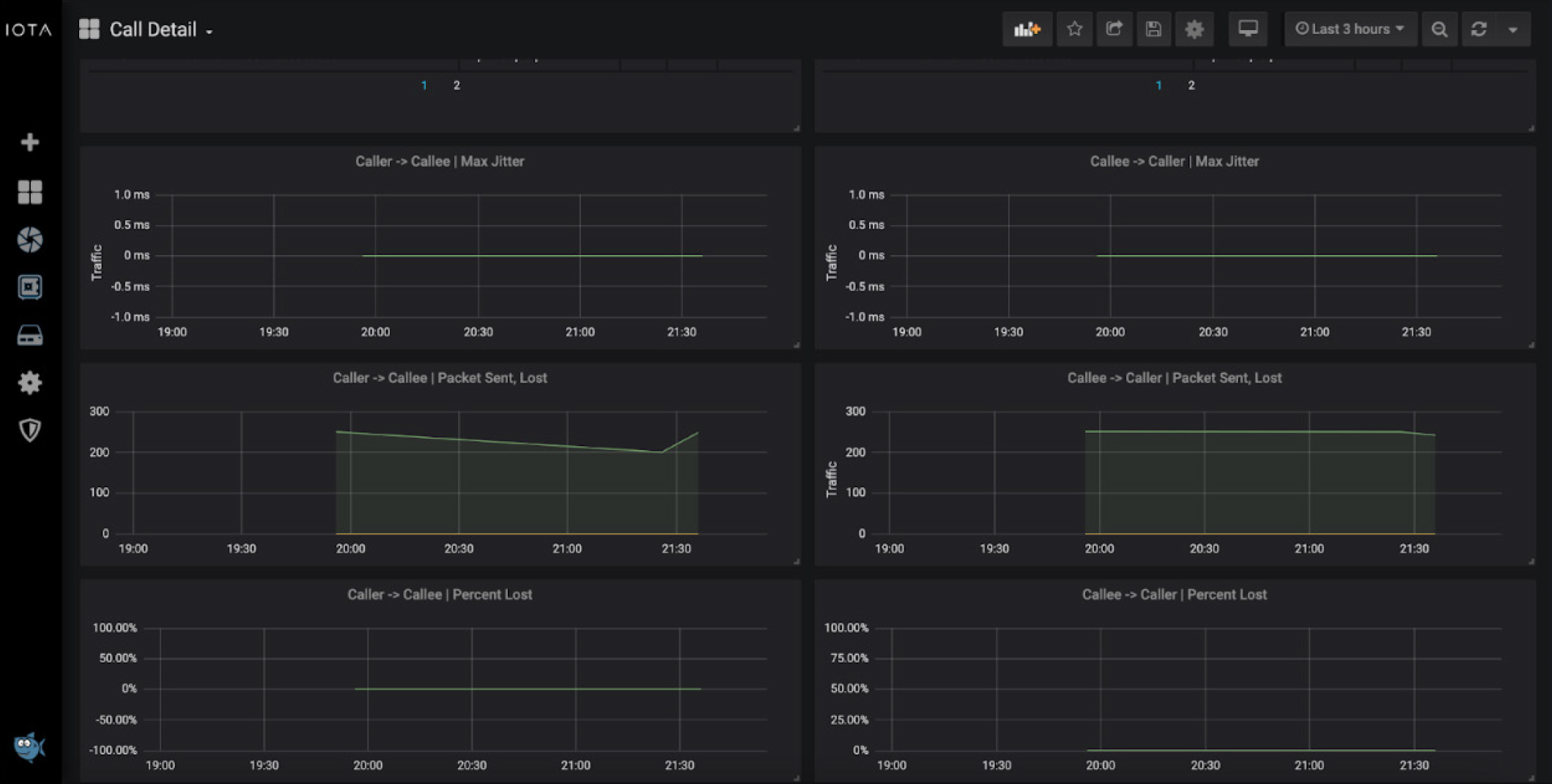

Für Qualitätsprobleme in der Übertragung der Sprachdaten im RTP-Datenstrom bietet das IOTA vielfältige Möglichkeiten. So gibt es ein vorbereitetes Call Detail Dashboard, dass jeweils von Anrufendem und Angerufenen separiert den Jitter und Paketverluste angibt. Die Anzeige von Paketverlusten gibt die Werte sowohl prozentual zu der Gesamtanzahl an Paketen an, als auch in der reinen Menge an Paketen, die verloren wurden. Neben den übersichtlichen Grafiken bieten sich auch Filter mit „>=“ an. So können Anrufe mit Paketverlusten und Jitter über bestimmten Schwellwerten, wie beispielsweise Jitter >= 20ms herausgefiltert werden.

Aber auch das „Click-and-Drag“ in den Grafiken bietet die Möglichkeit, bei festgestellten Auffälligkeiten, gezielt in einen Zeitbereich zu springen. Ein Einfaches „Click-and-Drag“ mit der Maus genügt dabei, um den Zeitbereich einzuschränken. Erkennt der Netzwerkanalyst einen hohen prozentualen Anteil des Paketverlusts im Vergleich zu den übertragenen Paketen im Call Detail Dashboard, kann er die Call-IDs erkennen und diese in Filtern nutzen, um problematische Kommunikationsbeziehungen zu erkennen. Führt die Analyse eines Dead Air Effekts beispielsweise immer wieder zu einem bestimmten Portbereich könnte eine fehlende oder nicht ausreichende Firewallfreigabe ursächlich sein.

Dies bietet die Möglichkeit Tickets zu Verständigungsproblemen in der VoIP-Umgebung schnell vorqualifizieren zu können. Das IOTA ermöglicht es durch vielfältige Filtermöglichkeit, den Fehler immer näher einzugrenzen, um zum „Root Cause“ des Problems zu kommen.

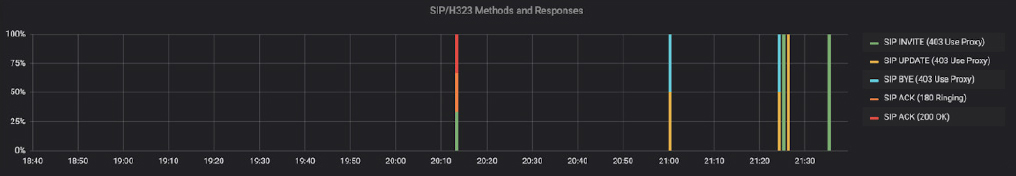

Aber auch im Bereich von Signalisierungsfehlern kann das IOTA einiges bieten. Um Muster von Signalisierungsfehlern erkennen zu können, bietet sich die in Abbildung 4 dargestellte Grafik „SIP Methods and Responses“ aus dem VoIP Dashboard an. Falls vermehrt „488 Not acceptable here“ sichtbar wären, würde dies beispielsweise auf eine Inkompatibilität der Codecs hindeuten. Bei „403“ Fehlercodes hingegen, dass der SIP-Proxy die Anfrage ablehnt.

Bei vermehrten „404 Not found“ Meldungen kann man gezielt einen Blick auf die Callee URIs im VoIP Dashboard werfen, um die fehlerhaften Zielrufnummern oder Zieldomains zu erkennen. Im Beispiel in Abbildung 4 sind einige 403 Responses sichtbar. Diese sind in der eingesetzten SIP-Authentifizierung begründet und somit vollkommen in Ordnung.

Bei einem verzögerten Gesprächsaufbau könnten auch die Latenzdaten der Signalisierung einen Aufschluss bringen. Bei SIP über TCP bietet die Round-Trip-Time einen ersten Ansatzpunkt. Diese kann das IOTA ebenfalls analysieren.

Für komplexere Fälle können auch gezielt PCAP-Daten heruntergeladen werden, um diese näher in Wireshark zu analysieren. So können bei unverschlüsseltem RTP und unterstütztem Codec auch die aufgezeichneten Audioinhalte im RTP-Player angehört werden, um sich unabhängig vom Telefon einen Eindruck von der Sprachqualität zu verschaffen. Sogar ein automatisierter Export von PCAP-Dateien auf eine externe Datenquelle ist möglich.

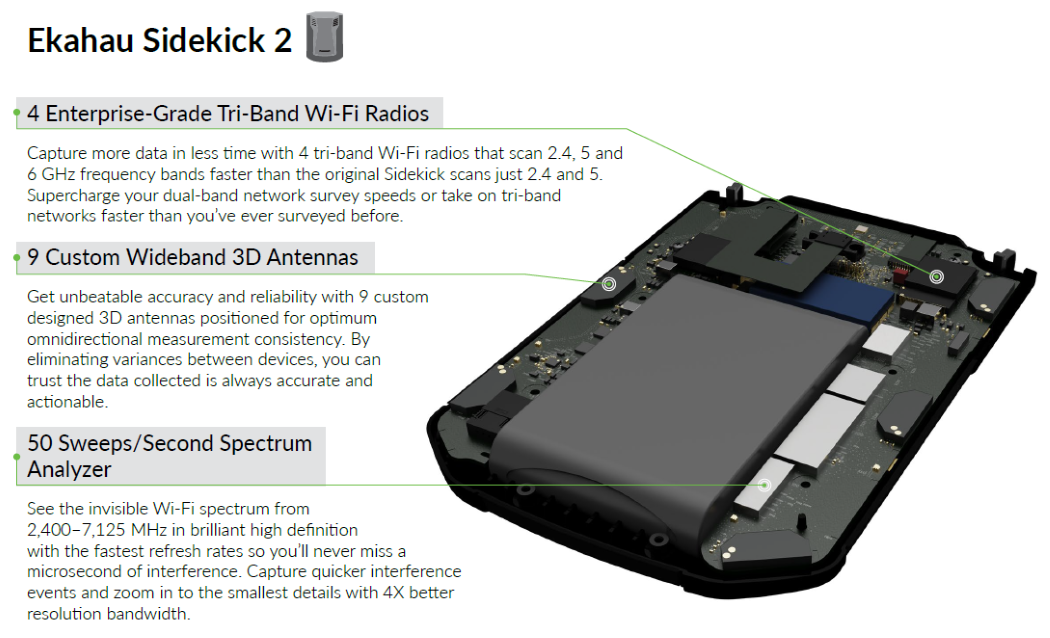

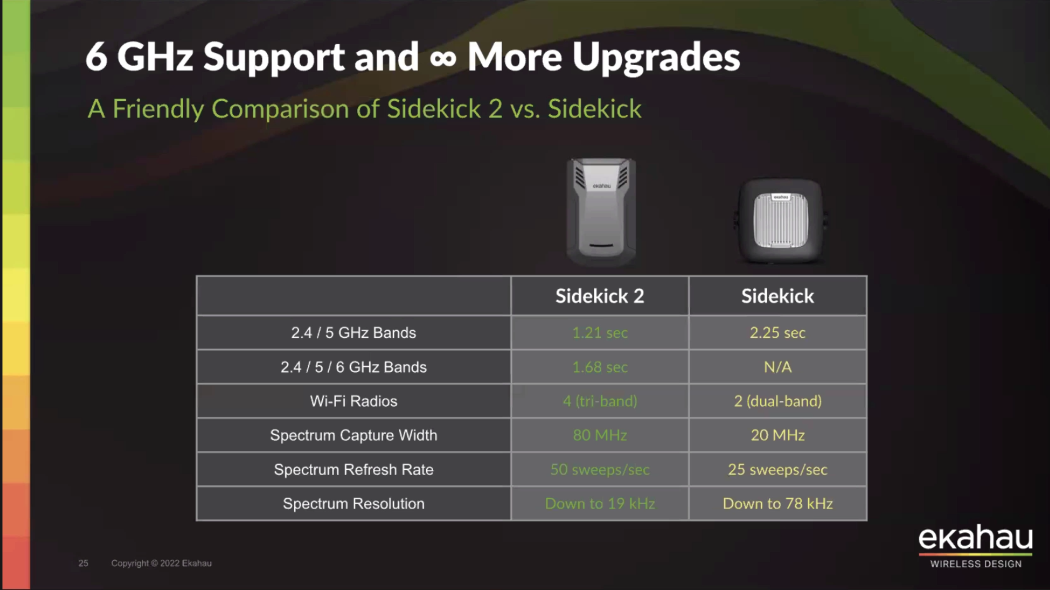

Nach 5 Jahren und einem neuen Frequenzspektrum (6GHz), was für WLAN die Zukunft werden kann, war es auch mal an der Zeit, dass etwas Neues kommt.

Mit dem Launch-Event am 21.07.2022 wurde der Sidekick 2 umfassend vorgestellt. Der Sidekick 2 ist ab sofort bestellbar und es gibt auch wieder eine Option für die Verlängerung der Hardware-Garantie auf 3 Jahre. Eine Möglichkeit zum Trade In für Sidekick 1 bietet Ekahau leider nicht an.

Der Sidekick 1 wird jedoch weiterhin in vollem Umfang unterstützt, die Firmware wird weiterentwickelt und er ist auch weiterhin ein toller Messbegleiter.

Ekahau hat mit dem Sidekick 2 auf seine Kunden gehört und einige Wünsche beachtet und Probleme beseitigt.

Was ist neu?

- Vier integrierte Tri-Band (2.4/5/6GHz) WLAN-Adapter

- Stark verbesserter Spektrum-Analysator mit 50 Sweeps und 19kHz Auflösung

- Deutlich größerer Akku erlaubt bis zu 16 Stunden Surveys am Stück

- 1 Stunde Schnellladen = 4 Stunden Survey

- Endlich ein USB-C-Anschluss mit Zugentlastung - damit die Anschlüsse nicht mehr kaputt gehen

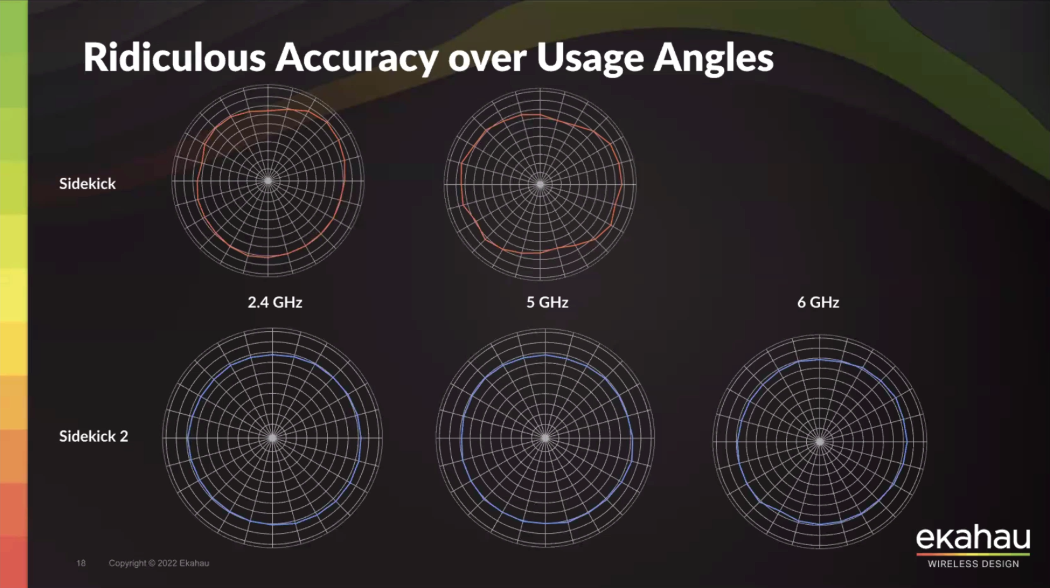

- Die Messgenauigkeit wurde deutlich erhöht

Die vier WLAN-Adapter sammeln entschieden mehr Daten und sind beim Scannen aller drei Frequenzspektren schneller als der Sidekick 1 mit zwei Frequenzspektren. Die Antennen wurden ebenfalls komplett überarbeitet und speziell für Ekahau entwickelt, um eine noch bessere und präzisere Aufzeichnung von Messdaten zu ermöglichen.

|

|

|

| Ekahau Sidekick 2 | Vergleich Sidekick 2 vs 1 - Scannen | Vergleich Sidekick 2 vs 1 - Antennen |

Für alle Infos schauen Sie doch mal auf unsere neue Sidekick 2-Produktseite.

Einen Blogeintrag von Ekahau mit ausführlichen Infos und Videos gibts hier:

Introducing Ekahau Sidekick 2 - Essential for High-Performing Wi-Fi

Um schnell eine Übersicht über den Status und die Performance Ihrer GeNiEnd2End-Umgebung zu bekommen, bieten wir schon länger die Möglichkeit an, Daten per SNMP / WMI oder die vom GeNiEnd2End Server integrierte JSON API abzufragen.

Welche Daten gesammelt werden können und in welchem Umfang, das wollen wir hier erläutern.

Warum sollte man überhaupt ein Network Performance / Application Monitoring Tool überwachen?

- Nicht jeder hat Zugriff auf GeNiEnd2End oder kennt sich damit aus, möchte aber den Status seiner Tests und Agenten sehen.

- Oft werden andere Monitoring Tools umfangreicher genutzt (z.B. PRTG) und diese können auch Daten von Ihrer GeNiEnd2End-Umgebung anzeigen.

- Ein leicht verständliches Dashboard für zum Beispiel externe Standorte, den Helpdesk oder Vorgesetzte kann einfach den Status Ihrer IT-Umgebung anzeigen und so die Fehlersuche vereinfachen sowie unnötige Ticketerstellung verhindern.

- Läuft ein GeNiJack, Agent oder Server mal nicht rund, kann dieser einfach in das Monitoring aufgenommen werden und das Problem somit näher eingegrenzt werden.

Welche Möglichkeiten haben wir in GeNiEnd2End, um Performance / Service-Metriken abzurufen?

Alle GeNiJacks verfügen über die Möglichkeit, Systemperformance und Service-Metriken per SNMP zur Verfügung zu stellen.

Ab Version 6.2.XXX werden auch die Zustände des GeNiAgenten und der anderen Services über SNMP ausgegeben. In älteren Versionen bedarf es manueller Anpassung einer Datei, damit auch dort die Daten gesammelt werden können. Es ist empfehlenswert, die GeNiJacks auf die aktuellste Version anzuheben. Bei weiteren Fragen dazu melden Sie sich bitte bei uns: support@netcor.de.

Alle GeNiAgenten auf einem Windows Betriebssystem können über WMI abgefragt werden - so wie bei jedem anderen Windows-Gerät auch. Um WMI zu aktivieren, kontaktieren Sie bitte Ihren Administrator. Hier gibt es oft Firmenvorgaben, ob und wie das geschieht.

Der GeNiEnd2End Server kann über WMI abgefragt werden und es gibt die Möglichkeiten, jede Form von Daten, die in den Datenbanken enthalten sind, über die REST API abzufragen. Diese gibt die angeforderten Daten als JSON (z.B. für Messwerte, Agenten Informationen) aus.

Was ist sinnvoll zu überwachen?

Der GeNiServer verwaltet und überwacht die Agenten bereits und generiert Alarme, liefert aber keine historischen Übersichten. Der Status der GeNiAgent Prozesse, die Erreichbarkeit und die Festplattenbelegung werden überwacht. Wenn Sie ein Problem mit einem GeNiAgenten oder GeNiJack haben, empfiehlt es sich, diesen genauer zu überwachen und/oder die Alarm-Benachrichtigung im GeNiServer entsprechend anzupassen.

| GeNiAgent und GeNiJack | GeNiServer |

Sinvoll

|

Sinnvoll

|

Möglich

|

Möglich

|

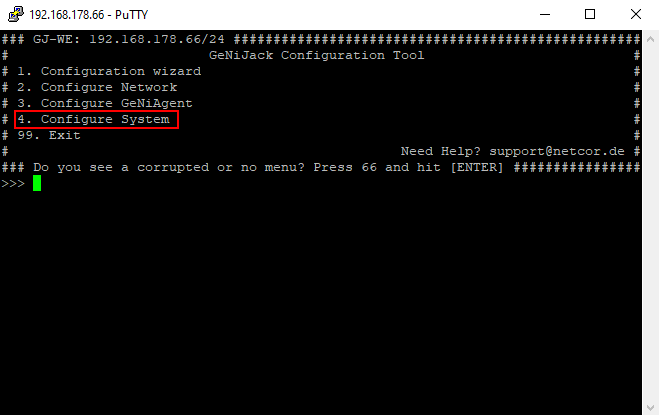

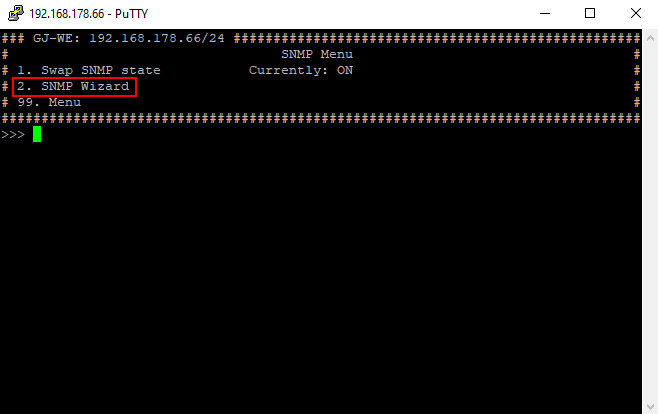

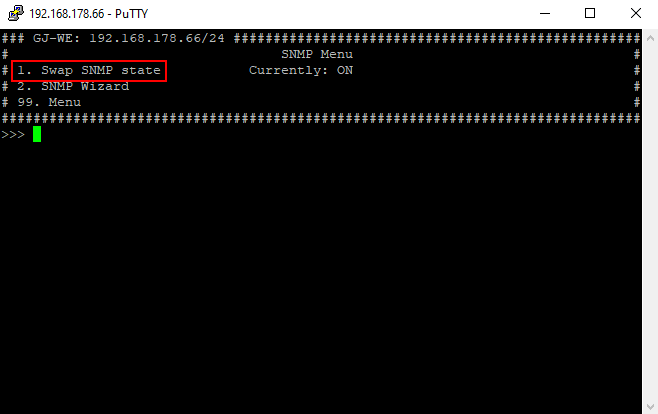

Wir aktiviere ich SNMP auf einem GeNiJack?

SNMP wird über SSH im GeNiJack Manager aktiviert und konfiguriert.

- Herstellen einer SSH-Verbindung zu einem GeNiJack und anmelden mit dem admin Benutzer.

- Im GeNiJack Manager Menüpunkt "4" auswählen, anschließened Menüpunkt "5".

- Jetzt den SNMP-Wizard durchlaufen, Menüpunkt "2" der die benötigten Daten für den SNMP-Dienst hinterlegt (z.B. Read/Write Community, Location usw.)

- Aktivieren des SNMP-Dienstes mit dem Menüpunkte "1".

- Jetzt das SNMP-Menü mit "99" verlassen mit und einen Reboot mit dem Menüpunkt "12" auslösen.

|

|

|

|

| System configuration | SNMP settings | SNMP Wizard | Swap SNMP state |

Jetzt können Sie mit der von Ihnen konfigurierten Read Community die Performance / Service-Metriken des GeNiJacks in Ihrem Monitoring Tool abfragen.

Wie kann ich die Performance / Service Metriken abfragen?

Wir zeigen nun an einem Beispiel von Paessler PRTG, wie man die Metriken abfragt und ein Dashboard erstellt.

Bevor Sie mit der Abfrage aller Geräte Ihrer GeNiEnd2End-Umgebung anfangen, sollten Sie sich überlegen, wo in Ihrem Gerätebaum und in welcher Struktur die Geräte integriert werden sollen. Wenn Sie eine einfache Übersicht über den Status aller Agenten und GeNiJacks haben wollen, empfiehlt es sich zwei getrennte Gruppen zu erstellen.

Abfragen aller Metriken der GeNiEnd2End-Umgebung:

- GeNiJacks / GeNiAgenten / GeNiServer in PRTG mit den passenden Sensoren (SNMP, WMI) hinzufügen.

- Um den Status von GeNiEnd2End-Prozessen auf den GeNiJacks anzuzeigen, ist ein spezieller SNMP-Sensor in PRTG notwendig.

- Den Sensor installieren: "Custom UCD-SNMP Linux Process v0.2"

Paessler Knowledgebase.

- SNMP muss nach der obigen Anleitung auf den GeNiJacks aktiviert und Version 6.2.XXX oder höher installiert sein.

- Bei allen GeNiJacks per Rechtsklick eine "Automatische Suche mit Vorlage ausführen" mit dem angegebenen Sensor.

- Sollten die Prozesse nicht erkannt werden überprüfen Sie, ob der GeNiJack auch auf der aktuellsten Version ist.

- Den Sensor installieren: "Custom UCD-SNMP Linux Process v0.2"

- Abfragen von Werten vom GeNiServer aus der Datenbank.

- Konfiguration der Poll-Intervalle für die Geräte.

Wie kann ich eine Übersicht über den Status/Performance der GeNiEnd2End Umgebung bekommen?

Das hängt natürlich immer von den Möglichkeiten des eingesetzten Monitoringsystems ab - diese sollten evaluiert werden.

Bei den meisten Monitoringsystemen gibt es eine Art von Dashboards, in PRTG werden diese auch Maps genannt. Dashboards liefern oft ein breites Spektrum von Anzeigemöglichkeiten, von Ampeln bis hin zu Charts und Tachos.

Wenn die GeNiServer REST API abgefragt werden soll, muss das Monitoringsystem mit der umfangreichen JSON-Rückgabe zurechtkommen. Es wird von der API immer der komplette Eintrag zu dem Test / Agenten, usw. zurückgeliefert.

Erstellen eines Dashboards:

Um einen Überblick zu bekommen, wie man eine Map in PRTG erstellt und welche Möglichkeiten es gibt, empfiehlt es sich folgende Informationen anzuschauen und dann mit unserem Guide fortzufahren.

Nachdem alle gewünschten Geräte hinzugefügt wurden und die Messwerte gesammelt werden, kann nun mit dem Erstellen des Dashboards begonnen werden. Wie in den verlinkten Videos von Paessler zu sehen ist, ist das eigentliche Erstellen einfach - vor allem wenn man sich ungefähr vorstellen kann, was dabei ersichtlich werden soll.

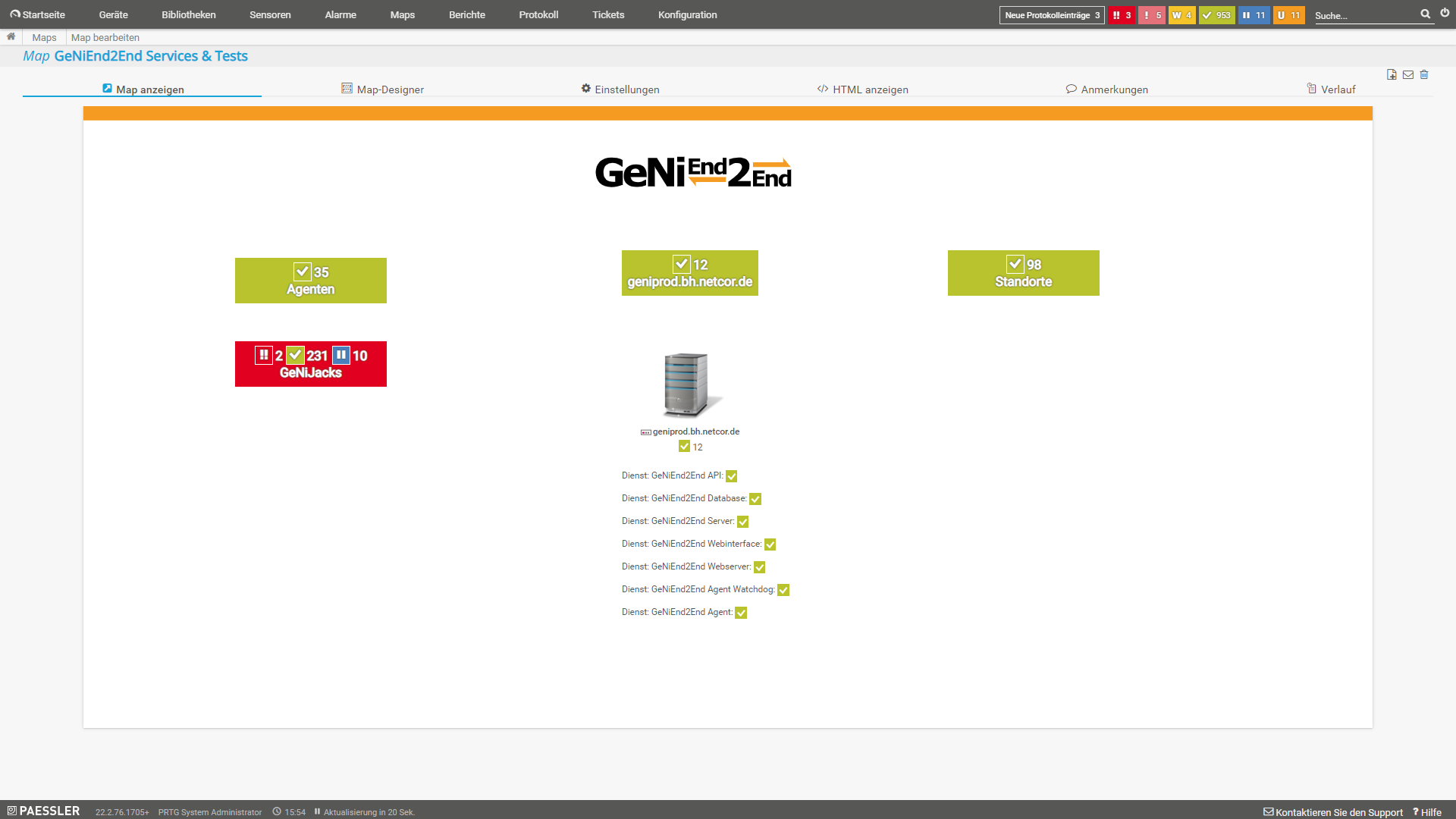

Ein Dashboard ist umso besser, desto einfacher und schneller man mögliche Fehler erkennt. Hierbei sollte man auch nach Detailgrad unterscheiden. Eine "einfache" Übersicht, die ausschließlich alle Agenten / GeNiJacks / Infos zum GeNiEnd2End Server und den Status der Tests anzeigt, ergibt für die schnelle Erkennung, ob ein Fehler wie im folgenden Beispiel vorliegt, besonders viel Sinn.

|

| Dashboard - GeNi Services |

Hier wurde für die meisten Anzeigen das Map Element "Name und Status (größenveränderlich, zustandsabhängiger Hintergrund)" genutzt und dann die entsprechenden Gruppen Agenten / GeNiJacks / GeNiServer sowie Standorte als Datenquelle genutzt. Damit ist schnell ersichtlich, sobald ein Element rot wird, ob und wo es ein Problem gibt.

Die Anzeigen der GeNiServer Services sind das Element "Name und Status (Standardhintergrund)", dort werden ausschließlich die Windows Dienste des GeNiServers als Datenquelle genutzt. Das Dashboard ist simpel und zeigt in dem Beispiel direkt einen Fehler bei den GeNiJacks an. Über ein Drill Down kann man zu dem Problem vordringen, das auf den GeNiJacks vorliegt. Wenn Sie möchten ist es auch möglich, eine "Alarmliste" auf dem Dashboard zu platzieren. Solch ein Widget sehen Sie auf dem Dashboard - Große Umgebung (simpel).

Allerdings können auch andere Darstellungen einen Mehrwert liefern, gerade wenn es um eine Übersicht von mehreren Standorten geht.

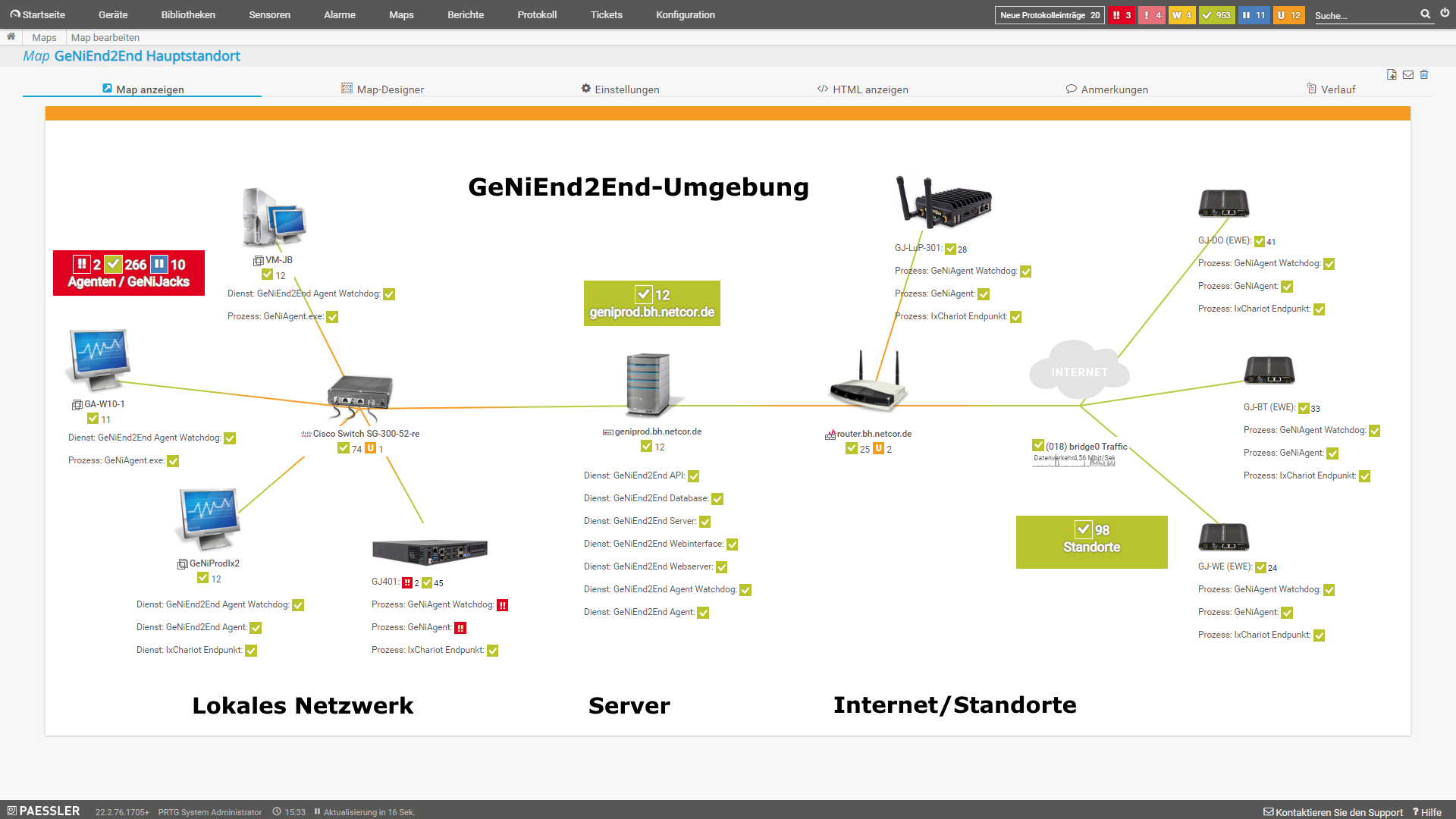

Hier gibt es ein paar Beispiele für verschiedene GeNiEnd2End Dashboards aus unserer PRTG Demo-Umgebung:

|

|

|

| Dashboard - Kleine Umgebung (ausführlich) | Dashboard - Große Umgebung (simpel) | Dashboard - Ring Darstellung |

Bei Fragen oder für weitere Informationen, melden Sie sich einfach bei uns.

Als Auswirkung von kurzzeitiger Überlast in Netzwerken, z.B. an Übergängen ins WAN, treten häufig Microbursts auf, die die Performance von Anwendungen merklich verschlechtern.

Leider werden diese Microbursts von den gängigen SNMP-Monitoring Lösungen aufgrund ihrer „groben Messauflösung“ nicht erfasst und stellen so die IT-Verantwortlichen vor eine große Herausforderung, die Ursache zu ermitteln.

Wir erklären Ihnen die Auslöser und Auswirkungen von Microbursts und zeigen Ihnen, wie Sie diese mit Wireshark oder noch effizienter mit dem

Allegro Network Multimeter analysieren können.

Als jemand, der Netzwerke plant, betreut und optimiert, haben vermutlich auch Sie häufiger die Herausforderung, dass Sie bei schlechter Applikationsperformance Probleme lösen sollen, die Sie eventuell gar nicht zu verantworten haben.

Durch die vermehrte Nutzung von SaaS und Cloud-Applikationen ist eine Fehlerzuordnung bzw. die Fehleranalyse noch deutlich schwieriger geworden: Herkömmliche Network Performance Monitoring Lösungen sind für private Netzwerkinfrastrukturen konzipiert. Ihre Architektur und Fähigkeiten sind nicht für Cloud-Umgebungen geschaffen, es gibt zwangsläufig Blind Spots.

In diesem Video zeigen wir Ihnen, wie Sie mit Hilfe der Kadiska Digital Experience Monitoring Platform Performanceprobleme von Cloud-Applikation (zum Beispiel Office 365, SAP und webbased Applikationen) analysieren können.

Als am 10. Dezember 2021 eine Zero-Day-Lücke in Log4j-Version 2 bekannt wurde, schrillten in zahlreichen Unternehmen die Alarmglocken.

Täglich werden Schwachstellen in Software gefunden, geschlossen und auch ausgenutzt. Der Unterschied zu den meisten vorherigen Sicherheitslücken lag darin begründet, dass nicht sofort erkennbar war, welche Software überhaupt Log4j beinhaltet und dadurch betroffen ist.

Immer öfter entsteht Software durch Zusammenfügen von mehreren fertigen und funktional ausgezeichneten Komponenten oder durch die Nutzung von fertigen Frameworks, die wiederum auch Abhängigkeiten von ihren Komponenten mitbringen. Ob benötigte Komponenten oder unnötiger Ballast: Die Nutzung von SBOM ist in der Theorie nach wie vor entschieden häufiger anzutreffen als in der Realität.

Und so standen dann im Dezember 2021 viele IT-Sicherheitsverantwortliche vor der Herausforderung, möglichst schnell beantworten zu können, an welchen Stellen Gefahr bestand.

Eine Möglichkeit, zügig und umfassend herauszufinden, wo Log4j in der benutzten Softwarelandschaft verwendet wird, bietet die Axonius Cybersecurity Asset Platform.

Auch wenn Log4j mittlerweile kalter Kaffee ist - eine nächste Sicherheitslücke an einer zentralen Komponente wird es geben. Wie Sie diese in Ihrer IT lokalisieren, erfahren Sie in diesem Video.

In dieser Aufzeichnung stellen wir Ihnen die Neuerungen der Version 6.2 von GeNiEnd2End vor.

Dies sind einige der Verbesserungen:

- Neuer iPerf3 Application Light Test

- Neuer Application FirstAid Test

- Neuer Network Test Wizard

- LLDP-Unterstützung

- Umstellung der genutzten Python-Version auf 3.X (Server, Agents, GeNiJacks, Scripte)

- Python-Version angepasst auf 3.x

- GeNiJack Debian-Version 10.10

Sollten Sie dazu Fragen haben oder Unterstützung bei dem Update benötigen, melden Sie sich gerne bei uns:

+49 4181 9092-110

support@netcor.de

Immer komplexer werdende IT-Infrastrukturen, ohne die die für den Unternehmenserfolg erforderlichen Prozesse gar nicht umsetzbar wären, erfordern neben ausgeprägtem Fachwissen auch hilfreiche Werkzeuge.

Diese sollen die IT-Verantwortlichen dabei unterstützen, einen reibungslosen Betrieb sicherzustellen und in einem eventuellen Fehlerfall die Ursache schnell zu erkennen und zu beheben.

Um auftretende Probleme unmittelbar erkennen oder gar vermeiden zu können, wird ein intelligentes 24x7 Monitoring der für den IT-Betrieb wichtigen Komponenten sowie der Verbindungspfade unverzichtbar.

Wir zeigen Ihnen, wie Sie Ihre Netzwerkinfrastruktur effizient mit Paessler PRTG überwachen können.

In einer Live-Demo erfahren Sie, wie eine schnelle Fehlerlokalisierung mittels einer Ende-zu-Ende Pfadanalyse bei einem Performanceproblem eines Webservers aussieht.

Ein weiterer Punkt ist die automatische Erstellung eines Netzwerkplans mit IP Fabric und wie Inkonsistenzen sowie Probleme beim BGP-Peering, die die Netzstabilität beeinflussen, automatisch identifiziert werden können.

18.06.2021

Dabei gehen wir auch darauf ein, wie eine intelligente Alarmierung proaktiv Fehler erkennt und den Workflow im Fehlerfall effizienter gestaltet. Ein weiterer Punkt ist die zielgenaue Analyse von Microbursts, Retransmission und Laufzeit mit

Wir verraten Ihnen auch, wie Sie verschlüsselten Datenverkehr analysieren können.

Seit SaaS- und Cloud-Dienste salonfähig geworden sind, hat sich in der IT viel geändert. Trotz der vielen Vorzüge der Auslagerungen der IT-Services, gibt es neue Herausforderungen beim Nachverfolgen der Verfügbarkeit und Performance dieser Dienste.

Es gibt neue Unsicherheitsfaktoren auf dem Netzwerkpfad von den Benutzern zur Cloud-Plattform. Das Maß an Kontrolle, das die IT-Abteilung darauf hat, ist im Vergleich zu den herkömmlichen Netzwerkinfrastrukturen gesunken.

Folgende neue Begleiterscheinungen beim Outsourcing in die Cloud können die User-Experience unkontrollierbar negativ beeinflussen:

- Die lokale Netzwerkkonnektivität im Home-Office

- Das Peering- und Transitverhalten

- Der Weg zum Sicherheitsgateway

- Die Auswirkungen der Optimierungen von BGP-Richtlinien und Routing-Tabellen

- Die Auswahl der CDN-Strategie und SaaS-Anbieter

- Die geographischen Ressourcen des Cloud-Anbieters

Durch diese Entwicklung ist es sinnvoll, die Service-User-Sicht, beziehungsweise den Netzwerkpfad vom Anwender zum Cloud-Anbieter, stärker ins Monitoring aufzunehmen.

Zum Glück gibt es Anbieter von Monitoringlösungen, die diesen Wandel erkannt haben und eine neue Sichtweise auf die globale User-Experience in den Vordergrund stellen.

Eine solche Sicht liefert zum Beispiel die Kadiska Digital Experience Monitoring Platform von Kadiska. Durch eine Kombination von synthetischen Tests und passives End-to-End-Monitoring können schnell Serviceverschlechterungen, deren Umfang und Ursache erkannt werden. Unverzichtbar für eine effiziente Problembehebung.

Bei Interesse stellen wir Ihnen Kadiska gerne vor - oder fordern Sie eine Teststellung an.

Wenn Anwender Schwierigkeiten bei der Nutzung wichtiger Applikationen haben, ist es insbesondere an Standorten ohne lokale Netzwerkspezialisten nicht einfach, Daten für eine Paketanalyse zu erhalten.

Wir zeigen Ihnen, wie Sie mit dem EtherScope nXG nah am Anwender Troubleshooting betreiben können - ohne selbst vor Ort sein zu müssen. Alle erforderlichen Daten werden automatisch erfasst und einem Spezialisten für eine Paketanalyse zur Verfügung gestellt.

Der kann sich dann mit Wireshark auf die Fehlersuche begeben.

Klagen Anwender über schlechte Antwortzeiten Ihrer Anwendungen, heißt es typischerweise „das Netzwerk ist heute wieder langsam"! Schnell ist der Netzwerkverantwortliche in der Pflicht.

Er muss nachweisen, ob die gemeldeten Probleme durch die Netzwerkinfrastruktur verursacht werden oder nicht. Als Hilfsmittel wird dabei gern auf Lösungen wie zum Beispiel iPerf zurückgegriffen.

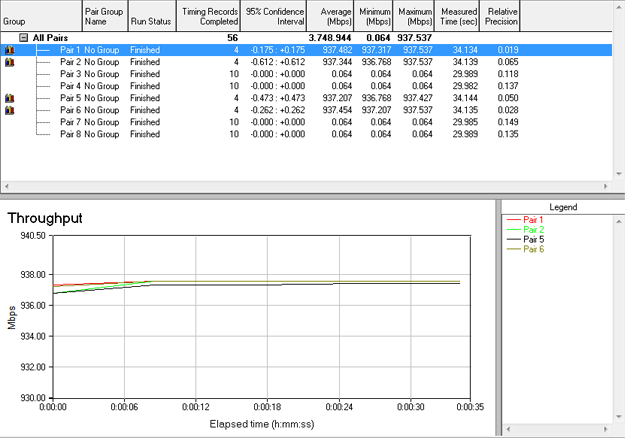

Wir erläutern Ihnen Einsatzszenarien für Ende-zu-Ende-Messungen und zeigen Ihnen Stärken und Schwächen von iPerf. Mit IxChariot stellen wir Ihnen ein Tool vor, dass einen sehr ähnlichen Ansatz wie iPerf hat, jedoch deutlich mehr Möglichkeiten bietet.

Im Zusammenspiel mit GeNiEnd2End erhalten iPerf und

IxChariot eine benutzerfreundliche Oberfläche, 24/7-Tests und reale QoS Test. Die Messergebnisse können dabei zur Reporterstellung genutzt werden - auch für externe Leistungserbringer und Provider.

28.04.2021

Wenn Anwender über schlechte Anwendungsperformance klagen, wird das Problem meist an den Netzwerkverantwortlichen weiter gegeben, um die Ursache dafür herauszufinden. Als Performancekiller können sich dabei Probleme mit TCP Window oder Application Blocksize herausstellen, die nicht auf die verfügbare Bandbreite optimiert wurden.

Wir beschäftigen uns in diesem Webinar mit den Grundlagen von Window Size und Application Blocksize. Zusätzlich zeigen wir Ihnen, wie Sie Retransmissions mit Wireshark analysieren und was verpasste TCP-Daten, Dup Ack und Retransmissions überhaupt in Theorie und Praxis bedeuten.

Da leider selbst Wireshark nicht für alle Aufgaben optimal ist, werfen wir einen Blick auf das Allegro Network Multimeter, das insbesondere bei Langzeitstatistiken und generell bei großen Capture-Files seine Stärken zeigen kann.

07.04.2021

Selbst ein zuverlässig geplantes und funktionierendes WLAN kommt eines Tages an seine Grenzen. Mit der Zeit verändern sich die Anforderungen an das WLAN durch technische Notwendigkeiten, weitere Prozesse benötigen drahtlosen Netzzugriff und die Erwartungen von Nutzern verändern sich ebenfalls.

Steht eine Modernisierung des WLANs an, stellt sich die Frage, ob man einfach 1:1 Access Points ersetzt oder ob es sinnvoller ist, anhand der gewachsenen Anforderungen, neuer WLAN-Standards und besserer Funkleistungen das WLAN vollständig neu zu planen.

Wie Sie eine WLAN-Modernisierung effizient mit Ekahau designen & validieren können, zeigen wir Ihnen in diesem Webinar.

Angetrieben von dem Wunsch der Effizienzsteigerung und der Hoffnung auf mehr Flexibilität werden nach wie vor Rechenzentren ausgelagert und Ressourcen zentralisiert.

Dadurch, dass Datenpakete dann einen anderen Weg als zuvor zurücklegen müssen, kann es zu Performanceproblemen kommen.

Gleichzeitig steigt nach einer Auslagerung auch die Komplexität bei der Erkennung und Analyse von eventuell auftretenden Performanceproblemen deutlich an.

Wir stellen Ihnen wichtige Parameter sowie Lösungsansätze vor, die Ihnen helfen, die Ursache/n für schlechte Performance effizient zu erkennen und zu beseitigen.

Für den praktischen Teile verwenden wir Riverbed SteelCentral AppResponse.

Nach wir vor sind deutlich mehr Mitarbeiter als in der Vergangenheit im Homeoffice. Für die Zusammenarbeit wird dabei auf Tools wie zum Beispiel GoToMeeting, Teams, WebEx und Zoom gesetzt.

Wie bei jeder anderen Applikation kann es auch hier zu Performanceproblemen kommen. Sie erfahren, wo die Herausforderungen bei der Analyse der Qualitätsprobleme liegen und mit welchen Messverfahren Sie bei Verwendung von TCP und UDP(IPSEC)/RTP herausfinden können, wo das Problem verursacht wird.

In der Live-Demo zeigen wir Ihnen mit realen Daten den Workflow der verwendeten Lösungen Allegro Network Multimeter und

NETCOR GeNiEnd2End.

Den erwähnten Artikel aus der LANline können Sie hier lesen:

Blinde Flecken beim SNMP-Monitoring - Die Last mit der Last

Häufige Änderungen an den Routing-Konfigurationen sind ein Anzeichen von der Instabilität des Peerings und können zu Netzstörungen oder sogar Ausfällen führen. Die klassischen SNMP-Monitoringtools sind meistens nicht in der Lage, diese Probleme zu erkennen.

Um Störungen in der Netzwerkredundanz frühzeitig erkennen zu können, empfiehlt es sich, die Betriebszustände der Netzwerkknoten kontinuierlich zu überwachen.

Mittlerweile gibt es Managementsysteme, die diesen Administrationsprozess automatisieren und Probleme - verursacht durch Änderungen in den Peering-Beziehungen - ohne Expertenwissen frühzeitig erkennen.

Im Video zeigen wir Ihnen, wie die Netzwerkinfrastruktur-Management-Plattform vom Hersteller IP Fabric Ursachen von BGP-Instabilität automatisch aufzeigen kann und nebenbei sogar eine aktuelle Netzwerkdokumentation liefert.

Auch wenn wir mit dem neuen GeNiJack 302 keinen Hype wie bei iPhone & Co. auslösen werden, wird dieser GeNiJack den Netzwerker nicht eiskalt lassen.

NETCOR GeNiJack 302 kann auch über WLAN messen

Einige Kunden planen den GeNiJack 302 zur Überwachung der Funknetze aus Anwendersicht in Meetingräumen einzusetzen. Somit kann der Netzwerker die End-User-Experience objektiver bewerten, was ihm eine effizientere Fehleranalyse bei Performanceproblemen ermöglicht.

Um die Übersicht über Ihr Netzwerk zu behalten, setzen unsere Kunden gerne das ![]() Network Multimeter von Allegro Packets als Ergänzung zu Wireshark ein. Die Benutzeroberfläche ist intuitiv zu bedienen, aber um es produktiv einsetzen zu können, ist es wichtig, die Zusammenhänge zwischen den gelieferten Messwerten des Network Multimeters herstellen zu können.

Network Multimeter von Allegro Packets als Ergänzung zu Wireshark ein. Die Benutzeroberfläche ist intuitiv zu bedienen, aber um es produktiv einsetzen zu können, ist es wichtig, die Zusammenhänge zwischen den gelieferten Messwerten des Network Multimeters herstellen zu können.

Allegro Network Multimeter

Ähnlich wie beim Förster, der weiß, was die einzelnen Bäume miteinander verbindet, sollte der Netzwerker das Wissen beherrschen, die Vielzahl der Echtzeit-Netzwerkstatistiken des Network Multimeters für die Fehleranalyse miteinander verbinden zu können.

Hierfür haben wir die praxisnahe Allegro Packets Schulung entwickelt. Entweder als Inhouse-Schulung oder auch als Webmeeting können unsere erfahrenen Consultants individuell auf die Teilnehmer und deren Vorkenntnisse eingehen. Gerne wird diese Schulung auch mit unserer Wireshark-Schulung kombiniert.

Also bevor Sie bei einem Netzwerkproblem den Wald vor lauter Bäumen nicht mehr erkennen und Sie die Kettensäge auspacken, buchen Sie besser unsere Netzwerkanalyseschulungen.

Schenken und beschenkt werden - beides bereitet Freude. Wir haben uns diese Woche ganz besonders darüber gefreut, wie uns ein Kunde sein Vertrauen geschenkt hat.

Bestellt hat er bei uns gleich 70 Exemplare vom ![]() GeNiJack 301. Auch wenn es der Regelfall ist, dass mehrere GeNiJacks eingesetzt werden, ist das schon eine überdurchschnittliche Größenordnung.

GeNiJack 301. Auch wenn es der Regelfall ist, dass mehrere GeNiJacks eingesetzt werden, ist das schon eine überdurchschnittliche Größenordnung.

70 GeNiJack 301 auf einen Streich

Da GeNiJacks bislang typischerweise nicht mal bei uns unter dem Weihnachtsbaum liegen, bleibt die Frage nach dem Ansinnen von unserem Kunden.

GeNiJack 301 verfügt über eine starke Quadcore CPU und kann so auch über einen längeren Zeitraum duplex voll ausgelastete Gigabit-Verbindungen messen.

In diesem Projekt wird der Kunde die GeNiJacks weltweit ausrollen und damit sein SDN monitoren. Sollte sich durch eine Konfigurationsänderung im SDN die Ende-zu-Ende-Performance verändern, bekommt der Kunde dies umgehend mit und kann so stets eine hohe Servicequalität ermöglichen.

Sollte es hartnäckige Netzwerkprobleme geben, kann die integrierte 500GB Festplatte für Packet Capturing genutzt werden. Die Daten können dann für Detailanalysen an ![]() Wireshark weitergereicht werden.

Wireshark weitergereicht werden.

Durch die Episoden führt Sie ein Kollege, der seit mehr als 10 Jahren Anwender im sicheren Umgang mit Wireshark schult.

Teil 1: Einführung in Wireshark

Teil 2: Strategien und effizienter Einsatz von Wireshark

Teil 3: Mit Wireshark gemessene Daten visualisieren

Ekahau hat am 09.04.2019 Neuigkeiten zu Ekahau Site Survey bekanntgegeben.

Ekahau Site Survey heißt jetzt Ekahau Pro und es gibt keine Standard-Version mehr.

Es wurde Ekahau Pro 10 mit folgenden Verbesserungen freigegeben:

- Überarbeitetes und deutlich schnelleres Benutzerinterface

- 802.11ax Unterstützung (APs, Erkennung und passive Messungen)

- Erkennen und Klassifizieren von Interferenzen

- Verbesserte AP Liste

- Verbesserte AP Lokalisierung

- Bei dem Sidekick wurde der integrierte Speicher freigeschaltet (128GB)

Kunden mit einem aktiven Supportvertrag können die Version hier herunterladen: ![]() Ekahau Download

Ekahau Download

Dazu kommt noch ein neues Supportprogramm, genannt Ekahau Connect, was vor allem für Nutzer mit

Ekahau Sidekick gedacht ist.

Dieses Supportprogramm bietet einige sehr interessante Vorteile, die Sie ab sofort erhalten können.

Ekahau Connect beinhaltet:

- Ekahau Survey for iPad

- Ekahau Capture

- Ekahau Cloud

- Ekahau Connect Training

Weitere Infos dazu finden Sie auf der Ekahau Connect Produktseite.

Durch die umfassenden Änderungen haben sich die Preise geändert und es gibt neue Artikelnummern.

Bei Fragen oder für weitere Informationen, melden Sie sich einfach bei uns.

Ekahau hat ein sehr informatives Webmeeting (Englisch) zum Thema WLAN-Interferenzen gehalten, was über Youtube angeschaut werden kann.

Es behandelt unter anderem folgende Themen:

- Was sind Interferenzen?

- Typen von Interferenzen

- Typische Quellen von Interferenzen

- Wie beeinflussen Interferenzen die WLAN-Verbindung - mit Beispielen

Von Uila AA-IPM unterstützte Cloud Anbieter

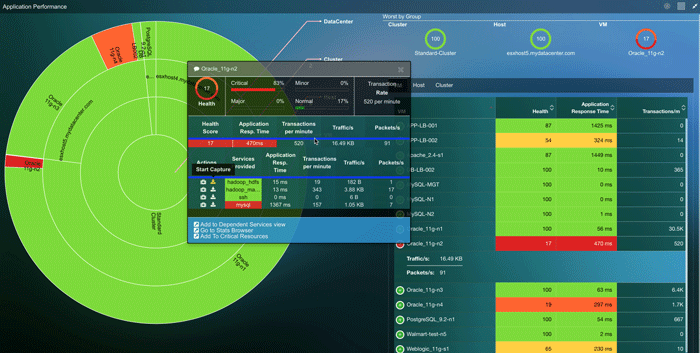

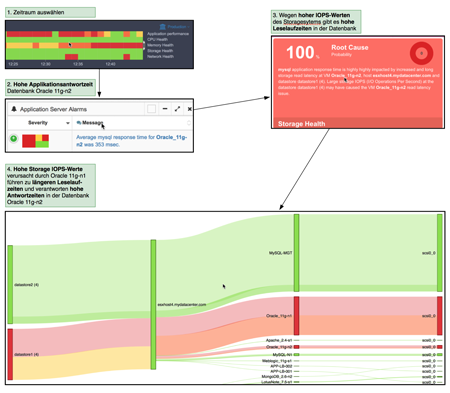

Die Übersicht der Serviceabhängigkeiten kann auch aufzeigen, welche VM- \ Service-Probleme durch eine andere VM entstehen, wenn z.B. der Webserver die Datenbank einer anderen VM abfragt und dadurch die Antwortzeiten des Webservers "langsam" sind. Hier hilft auch die Root Cause Analyse Funktion, um den eigentlichen Verursacher auf den Zahn zu fühlen.

Interesse an Uila AA-IPM? Sie können es in unserem

NETCOR Performance Check 30 Tage kostenlos testen.

20.02.2018

Wenn Geschäftsapplikationen immer wieder haken und das System Monitoring durch die Flut an nicht korrelierten Performancedaten den gewünschten Rückschluss auf den/die Verursacher nicht darstellen kann, bleiben die Performanceprobleme im Dunkeln.

|

Bei den klassischen Management-Tools in virtualisierten Rechenzentren werden grundlegende Performancedaten wie CPU-, Speicher-, Storage und Netzwerkauslastung gesammelt, allerdings liefern diese Kennzahlen erstmal eine quantitative Aussage zu der Performance. Sie liefern aber keinen Rückschluss zu den Applikationsantwortzeiten. Diese Überwachungslücke wird mit der |

|

Die Uila AA-IPM Software ist eine schnell zu implementierende und bezahlbare Lösung für eine anwendungsorientierte Überwachung von der Private- und Hybrid-Cloud.

Für den AirCheck G2 ist eine Neue Firmware Version erschienen die bei aktivem Gold Support einfach heruntergeladen und installiert werden kann.

Diese beinhaltet einige wichtige Features, die schon lange auf der Wunschliste standen:

iPerf Testing:

Endlich ist es möglich, direkt mit dem AirCheck G2 iPerf Tests (TCP/UDP) gegen einen iPerf Server durchzuführen.

Captive Portals:

Es ist jetzt möglich, WLAN-Verbindungen zu überprüfen die mit einem Captive Portal gesichert sind. Es ist auf dem Gerät im Profil für die WLAN-Netzwerke hinterlegbar.

Interferer Detection - Störererkennung:

Der AirCheck G2 zeigt nun auch Störer im 2.4 GHz und 5 GHz Bereich an. Das ist enorm hilfreich, um Geräte zu erkennen und aufzuspüren, die das WLAN stören aber selber nicht per WLAN kommunizieren. Hierunter fallen viele Geräte wie drahtlose Telefone, drahtlose Videokameras, Bewegungsmelder usw. Um solche Störer aufzuzeigen war es vorher immer nötig, den AirMagnet Spectrum XT gleich dabei zu haben. Jetzt kann erstmal geschaut werden, ob es Probleme gibt und dann werden sie mit dem

AirMagnet Spectrum XT weiter eingegrenzt.

Autorisationsklassifizierung:

Es ist nun möglich, WLAN-Geräte zum Beispiel danach zu klassifizieren, ob diese zu dem Unternehmen gehören oder ein Gerät eines Nachbars sind oder ein unbekanntes Gerät (Rogue).

Hier gibt es den Download der neuen Version : AirCheck G2 Gold Support benötigt

Hinweis: Für den Download der Firmware V2 benötigen Sie einen aktiven Gold Support für den AirCheck G2. Sollte Ihnen dieser noch fehlen, können Sie sich gerne für ein Angebot bei uns melden.

Ein Video das die neuen Funktionen zeigt gibt es hier (Englisch):

Es gibt Problemfälle, in denen die Informationsdichte auf Basis der Datenpakete für die Fehleranalyse im ersten Schritt zu detailliert ist. Ohne konkrete Anhaltspunkte ist eine Analyse von Terabyte großen Tracefiles - in denen lediglich eventuell der Fehler steckt - nicht zielführend. Es fehlt der Überblick, auch gerade in Hinblick auf die Zeitdimension.

Um mehr Überblick zu bekommen, empfehlen wir unseren Kunden das Network Multimeter von Allegro Packets. Es handelt sich hier um eine mobile Problemdiagnose-Lösung in unterschiedlichen Systemgrößen, geeignet für den Einsatz in 1G/10G/40G und 100G Netzen. Die intuitive und webbasierende Benutzeroberfläche liefert sowohl eine Echtzeit- als auch eine rückwirkende Sicht auf den Netzwerkverkehr und unterstützt einen strukturierten Workflow bei der Problemdiagnose.

Benutzeroberfläche vom Allegro Network Multimeter

Es werden wichtige Metadaten über alle Netzwerkschichten erhoben und ein PCAP-Datenmitschnitt kann permanent oder bei Bedarf selektiv aktiviert werden. Außerdem besticht das leistungsfähige Network Multimeter mit einem einmaligen Preis-/Leistungsverhältnis.

Überblick ist die halbe Miete, interessant wird es erst, wenn man ihn zum Durchblick weiterentwickelt. Mit dem Network Multimeter von Allegro Packets sehen Sie wieder den Wald vor lauter Bäumen.

Überzeugen Sie sich gern einmal in Form einer kostenfreien Teststellung davon.

Bei Performancebeschwerden der Anwender aus entfernten Lokationen ist für die Fehleranalyse ein SNMP-Überwachungstool unerlässlich. Der Netzwerkadministrator kann hierdurch schnell erkennen, ob die WAN-Verbindungen stark ausgelastet sind.

Allerdings können Microbursts - die meist nur wenige Millisekunden anhalten - bei den typischen Abfrageintervallen von 60 Sekunden oder höher nicht von einem SNMP-Monitoring erfasst werden.

Somit bleiben Auswirkungen, wie Paketverluste, im Verborgenen - was zu einer Fehlentscheidung bei der Ursachenanalyse führen kann. Dabei sind Paketverluste Performancekiller und bereits bei Paketverlustraten von 0,5% spüren Anwender schon Performanceeinbußen.

In der aktuellen Ausgabe des Fachmagazins LANline widmet sich ein Kollege diesem Thema und erklärt, wie Paketverluste bereits bei Auslastungen deutlich unter 100% zu Klagen der Anwender über langsame Anwendungen führen können.

Den LANline-Artikel erhalten Sie unter dem nachfolgenden Link:

Blinde Flecken beim SNMP-Monitoring - Die Last mit der Last

Es war auch langsam an der Zeit, dass sich im Bereich WLAN-Analyse mal etwas neues auftut. Es scheint als liefere Ekahau mit dem Sidekick einen echten "Game Changer".

Der Sidekick besteht aus zwei hochperformanten 802.11ac WLAN-Adaptern, gepaart mit einer unschlagbaren Spektrum-Analysator-Karte mit 20 Sweeps pro Sekunde. Dazu kommt noch ein Akku mit einer Leistung, die einem Arbeitstag entspricht. Das ganze dann hübsch, sicher, einfach und portabel in einem Gehäuse verpackt.

Perfekt für Surveys:

|

|

Der eingebaute Spektrum-Analysator ist so schnell und präzise, dass er im Vergleich zu anderen Spektrum Produkten eine neue Stufe von Detailreichtum aufzeigt. Laut Ekahau ist er 4x bis 10x schneller als vergleichbare Produkte und die Videos lassen wirklich darauf schliessen, dass dort eine neue Ära anbricht.

Da die Firmware des Gerätes aktualisierbar ist und das ganze direkt von Ekahau stammt, sind weitere Features möglich.

Durch den Sidekick entfällt auch die Notwendigkeit, mittels USB-Hub mehrere USB WLAN-Adapter an sein Notebook anzuschließen. Dadurch verschwindet nicht nur ein Kabel-/Adaptergestrüpp, mehrere Fehlerquellen verschwinden und der Akku von Notebook oder Tablet wird nicht belastet.

Last but not least ist es durch den Sidekick nun auch möglich, macOS im vollen Umfang für komplette Surveys zu nutzen, ohne auf etwas verzichten zu müssen bzw. Umwege über eine virtuelle Maschine gehen zu müssen.

Weitere Infos zum Ekahau Sidekick gibt es hier: Ekahau Sidekick

BYOD, Cloud und IoT weichen die Netzwerkgrenzen von Firmennetzwerken auf. Klassische Netzwerkperimeter- lösungen reichen heute alleine nicht mehr aus, um Angreifer, die bereits im Netz sind, zu erkennen. Deshalb werden neue Ansätze benötigt, um Angriffe außerhalb des Überwachungsbereichs der Perimeterlösung aufzeigen zu können. Ein komplementärer Ansatz wäre, die Netzwerkinfrastruktur gemäß des Cisco Konzepts „Network as a Sensor“ selbst als Datenquelle zu nutzen. Durch Aktivierung von Netflow/IPFIX auf Routern, Firewalls, VMware usw. werden Metadaten von IP-Verkehrsströmen an ein Security-Analytics-System für die Auswertung weitergeleitet. Dieses Anomalie-Erkennungssystem kann dann verdächtige Verkehrsströme, Richtlinienverstöße und kompromittierte Endgeräte erkennen.

Die Network Traffic Analytics Sofware

Durch Partnerschaften und Technologieintegrationen mit Firmen wie z.B. Cisco, Juniper, Gigamon, Ixia, Palo Alto Networks, Citrix, VMware, Extreme Networks, Endace, Splunk bietet Scrutinizer auch die Möglichkeit, proprietäre Metadaten der soeben aufgeführten Hersteller auszuwerten. Informationen zu den spezifischen Metadaten der Hersteller gibt es unter:

Bei Interesse stellen wir Ihnen Scrutinizer gerne vor oder fordern Sie eine

Wenn Sie einen Fensterplatz im Flieger ergattert haben, erhalten Sie beim Abflug und Landung eine Sicht auf Wasserwege, das Straßennetz und sehen, wie die Orte angebunden sind und ob es aktuell zum Beispiel Staus gibt.

Aber auf dem Boden - wenn wir am meisten davon profitieren könnten - ist es meist schwierig, diese Zusammenhänge schnell zu verstehen.

Betreiber von virtualisierten Datacentern haben hier eine ähnliche Herausforderung. Es gibt viele spezialisierte Monitoringtools, die aber nicht die Weitsicht für das schnelle Auffinden von Performance-Engpässen liefern.

Dabei bietet die Vogelperspektive eine gute Methode, um aufzuzeigen, wie alles „miteinander verbunden“ ist, beziehungsweise die Möglichkeit Wichtiges von Unwichtigem zu unterscheiden.

Die

Im nachfolgenden

Wer fliegt kann die Dinge und deren Zusammenhang sehen und bewerten.

Wer fliegt muss nicht enge und vollgepackte Wege gehen und kommt zwangsläufig schneller an.

Buchen Sie sich einen

Über die letzten Jahrzehnte hat sich in der IT viel verändert und getreu dem Motto „schneller, höher, weiter“ wurden vom Client über das Netzwerk bis hin zu den Servern immer leistungsfähigere Systeme entwickelt, die die Arbeitsprozesse in den Unternehmen enorm beschleunigt haben. Diese Veränderungen sind unverzichtbare Grundlage für den Unternehmenserfolg vieler Firmen.

Leider geht diese Entwicklung, trotz ausgeklügelter Prozessmodelle wie ITIL oder eTOM, selten mit einer zuständigkeitsübergreifenden Arbeitsweise der Fachabteilungen einher. Netzwerker, Serveradministratoren und Client-Betreuer legen den Fokus auf ihren Zuständigkeitsbereich und verweisen im Fehlerfall gern mal darauf, dass ihre Überwachungssysteme auf „grün“ stehen und das Problem nicht in ihren Zuständigkeitsbereich fällt. Dummerweise können die Kollegen aus den anderen Bereichen mit ebenfalls „grünen“ Werten aufwarten und das „Schwarze-Peter-Spiel“ beginnt.

Zum Glück gibt es Unternehmen, die diese Barrieren überwinden und fokussiert die Zufriedenheit des Endanwenders in den Vordergrund stellen. Dafür ist aber eine einheitliche Sicht auf die Anwendungsperformance der Systeme erforderlich.

Eine solche Sicht liefert zum Beispiel die Lösung

Mögen viele weitere Unternehmen diesem guten Beispiel folgen.

Häufig erfahren die IT-Administratoren erst durch ihre Anwender von Performance-Problemen und leider nicht von den eigenen Monitoring-Tools. Allerdings erschweren die typisch vagen Aussagen, wie z.B. „es dauert ewig“, die zielorientierte Ursachenanalyse. Und die hohe Komplexität in den stark virtualisierten Rechenzentren macht eine Analyse auch nicht einfacher.

Hier fehlt es meist an einer integrierten, korrelierten Ende-zu-Ende-Sicht über alle Ebenen. Wir empfehlen hier unseren Kunden den Einsatz einer Full-Stack-Monitoring-Lösung von der Firma Uila. Diese Software bietet:

- Das Monitoring von den physikalischen und virtuellen Systemen

- Die Überwachung aller Teile der Datacenter-Infrastruktur, von Netzwerk-, Storage- bis zur Applikationsebene

- Eine Beurteilung der gesamten Kette, angefangen bei der Infrastruktur über die Anwendung bis zu der aktuellen End-User-Experience

- Eine Korrelation der unterschiedlichen Ebenen inkl. Visualisierung der Rechenzentrumtopologie und den Abhängigkeiten

- Eine Root-Cause-Analyse für eine effiziente Analyse von Performanceproblemen

Im

Am besten überzeugen Sie sich von der 360-Grad Cockpitansicht der Uila Software indem Sie eine

kostenfreie

Welcher IT-Administrator kennt das nicht: Ein Anruf eines Anwenders, der anfängt mit „warum ist alles so langsam?“. Diese oder ähnliche Fragestellungen hat jeder schon mal für die unterschiedlichsten Performanceprobleme auf den Schreibtisch bekommen. Wenn der Anrufer dann noch zum Management gehört, fängt jeder hektisch an, im eigenen Fachbereich das gemeldete Problem zu analysieren. Niemand möchte den „Schwarzen Peter“ zugeschoben bekommen und versucht, seine Unschuld - mit den ihm verfügbaren Informationen - zu belegen.

Selbst wenn das Problem von alleine wieder verschwindet, tickt da eine Zeitbombe, die irgendwann mal wieder hochgehen kann.

Gerade bei dieser Art von sporadischen Performancestörungen kann nur mittels einer schrittweisen, strukturierten Vorgehensweise nach dem Ausschlussverfahren dem Problem auf den Grund gegangen werden. Leider gibt es (noch) nicht das ultimative Werkzeug, das leicht bedienbar ist, alles kann, proaktiv Fehler erkennt und sogar Lösungsvorschläge anbietet. Wunschdenken und Wirklichkeit liegen hier weit auseinander.

Also was ist bei der Fehlersuche von sporadischen Problemen zu beachten:

- Genaue Fehlerbeschreibungen erstellen. Erst soll das Problem verstanden werden bevor man mit der Analyse beginnt.

- Versuchen, die sporadischen Probleme auf Teile der IT-Infrastruktur, welche eine Ursache darstellen können, zu reduzieren. Hierfür können dann Daten mit maximaler Detailtiefe erhoben werden.

- Fokus der Performance-Kennzahlen aus dem Bereich Qualität. Typischerweise erheben die gängigen Monitoring-Systeme Kennzahlen aus dem Bereich Quantität (z.B. CPU- und Leitungsauslastung) aber häufig fehlt es an Qualitätskennzahlen wie z.B. Paketverluste und Applikationsantwortzeit.

- Eingesetzte Analysetools sind vom „Problem“ abhängig zu machen und nicht umgekehrt.

- Nach Eingrenzung des Problembereichs sind Experten aus dem jeweiligen Bereich hinzuziehen.

Ohne ausreichend Zeit, die richtigen Werkzeuge und die notwendigen Kenntnisse lassen sich in den heutigen, komplexen und redundanten IT-Infrastrukturen sporadische Performanceprobleme nur schwer analysieren und lösen.

Wenn Sie in dieser Situation eine „unabhängige“ Unterstützung benötigen, dann sind Sie bei uns gut aufgehoben. Gerne übernehmen wir auch das „Management“ von Eitelkeiten der Beteiligten.

Mit unserem langjährigen & fokussierten Wissen, garniert mit unserem umfangreichen Fuhrpark an Analysetools, bietet unsere

Willkommen zurück zu unserer Blog-Serie über GeNiEnd2End Skripting!

Als letzten Teil der Serie stelle ich ein paar unserer Skripte, die wir selbst in Betrieb haben, vor.

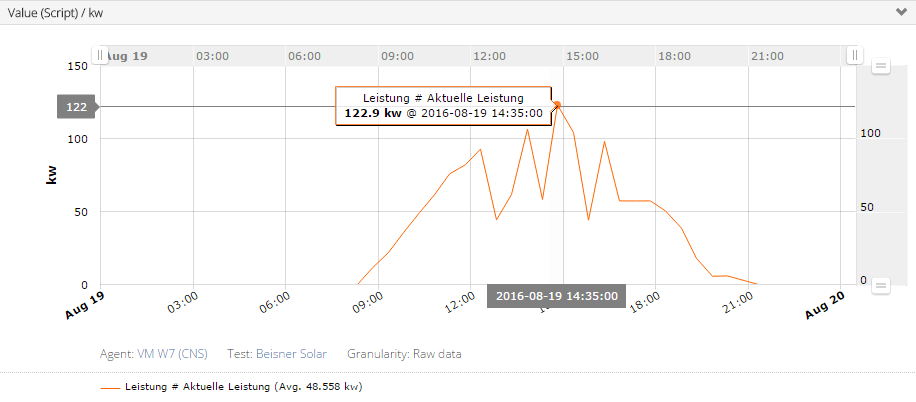

Viele der Skripte sind zum Kennenlernen der Skriptingsprachen erstellt worden und dann später für den produktiven Einsatz überarbeitet worden. Die Skripte Beisner Solar und Temperatur Erfassung dienen ausschließlich dazu, Messwerte für unsere Demosysteme zu sammeln.

Die Darstellung der Messwerte gibt es natürlich nicht nur für einen Tag, sondern auch Wochen, Monat, Jahr - ganz nach Wunsch dann im GeNiEnd2End.

Ab GeNiEnd2End Version 5.2 (Geplant für Ende des Jahres) ist auch wieder die Aggregierung von Messwerten enthalten.

Beisner Solar:

Beisner Druck ist ein Nachbarn in Sichtweite unserer Hauptniederlassung und seitdem deren Standort eine moderne Solaranlage installiert hat, zeigen sie die dadurch gewonnenen Kilowatt auf ihrer Website an. Ein Skript holt die Messwerte von der Website ab und liefert diese in GeNiEnd2End. Die Chart zeigt ausschließlich die aktuelle Leistung der Solaranlage an.

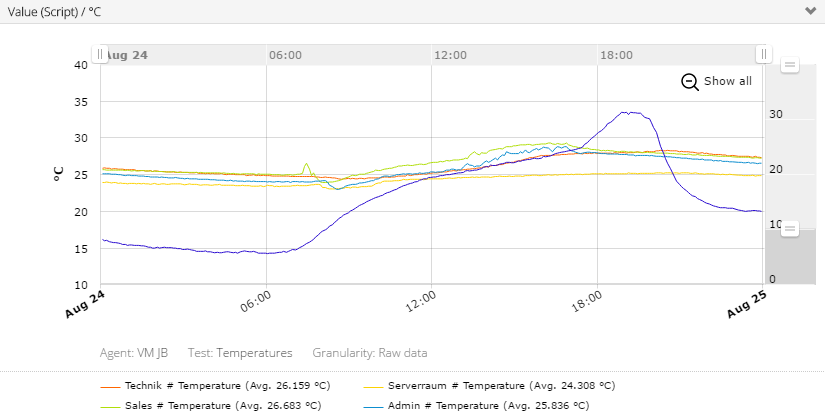

Temperaturerfassung:

Seit einigen Jahren zeichnen wir die Temperaturwerte einiger Büroräume auf und nutzen es auch zur Notifikation wenn Schwellwerte überschritten werden.

Sofern die Temperatur des Serverraums einen Schwellwert überschreitet wird ebenfalls eine eMail verschickt, direkt durch das Skript.

Ja, der Serverraum ist zu warm, die große Klimaanlage ist defekt und der vorrübergehende Ersatz schafft leider keine ausreichende Luftzirkulation im Raum. Die blaue Linie ist die Aussentemperatur, in Anbetrachtet dessen, hat sich die kleine Aushilfsklimaanlage doch ganz gut gehalten (Serverraum ist die gelbe Linie).

Am Ort der Messung staut sich die Hitze, die Position wurde mit Absicht gewählt :), und zeigt somit immer den schlechtesten Wert im ganzen Raum an.

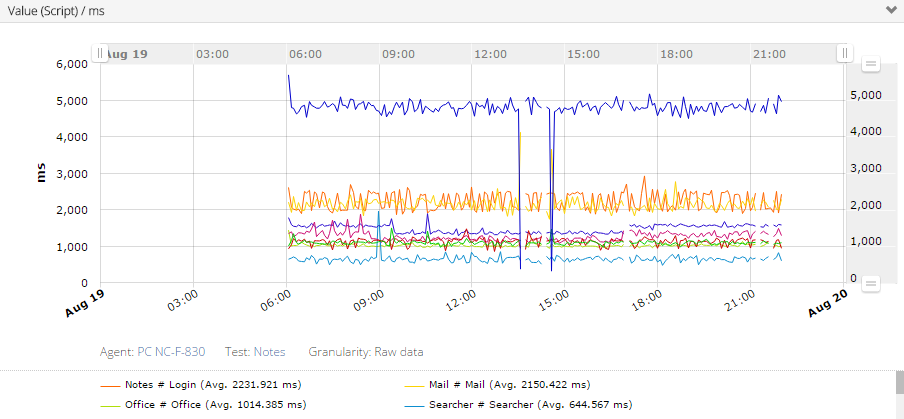

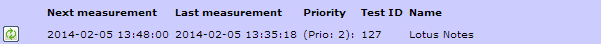

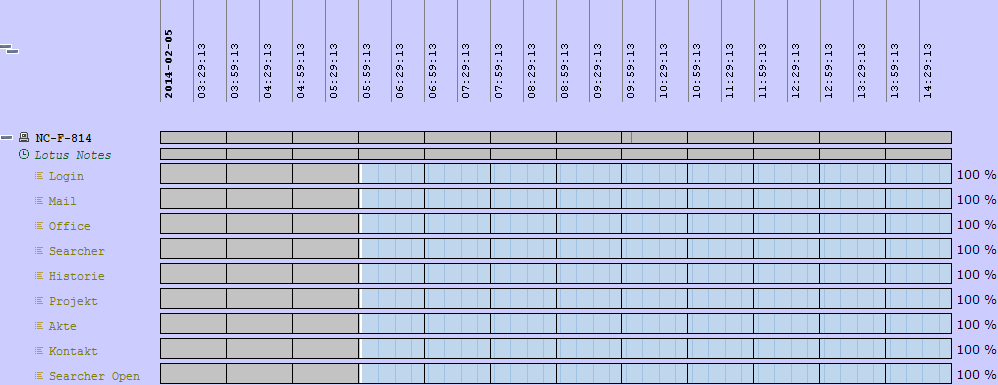

IBM Notes:

Entstanden ist das Skript, um zu zeigen, dass die Bilderfassung stabil und schnell funktioniert. Inzwischen ist das Skript seit 5 Jahren durchgängig als Liefrant für Messwerte aktiv.

Es hat uns auch schon geholfen, Performanceveränderungen aufzuzeigen und den Verursacher ausfindig zu machen. (Siehe Link unten)

Der inzwischen benutzte Roboter hat einen großen Nachteil: Er verfügt über keine richtige Grafikkarte und das spürt man bei dem Benutzen des Notes Clients bzw. das spiegeln auch die Messwerte wieder. Die kurzen Ausfälle sind gewollt, um auch Fehlerstände zu zeigen.

Von 22:00 bis 06:00 ist eine Primetime aktiv, also wird in dieser Zeit keine Messung durchgeführt.

Link zum alten Blog Eintrag (Alte Messwerte):

DHCP + DNS + Traceroute:

Aus Kundenwünschen bzw. durch Bedarfserkennung entstanden und inzwischen Standard Skripte von GeNiEnd2End Application. DHCP zeigt die DHCP Offers an und wie viele Server auf die Anfrage geantwortet haben und in welcher Zeit.

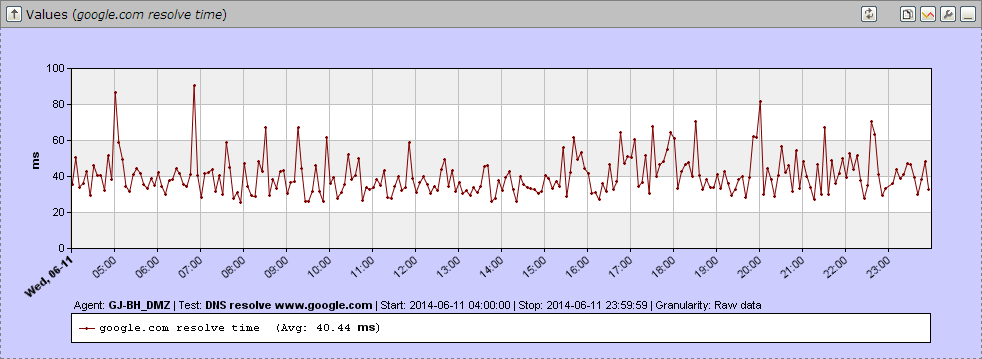

DNS zeigt an, wie lange die DNS-Abfrage gedauert hat und der Traceroute-Test zeigt Veränderungen an der Anzahl der Hops auf.

|

|

|

DHCP DHCP |

DNS DNS |

Traceroute Traceroute |

File Transfer (SMB/CIFS Dateiübertragung):

Probleme mit dem SAN bzw NAS erkennen? Kein Problem! Die SMB Skripte führen einen Dateitransfer oder Transfer mehrerer Dateien durch. Die Größe der Datei/en ist angebbar, Messwerte sind jeweils die Dauer und Geschwindigkeit von Up- und Download.

|

|

Eine Datei 10MB Eine Datei 10MB |

100 Dateien je 20KB 100 Dateien je 20KB |

Anderes:

Skripte für Kunden, um Verfügbarkeit bzw. Performance für interne Websites, Online Banking, Zimmerreservierungen, Messungen in und rund um Citrix aufzuzeigen. Sogar LTE-Verbindungsmessungen haben wir bereits durchgeführt. Natürlich alles mit Alarmierung durch GeNiEnd2End bei Nichtverfügbarkeit oder unter- bzw. überschreiten von Schwellwerten.

Natürlich gibt es auch vieles, was nur internen Bedarf oder Spielereien abdeckte.

Darunter verschiedene Skripte die Commandos per SSH ausführen und deren Durchführung + benötigte Laufzeit dann aufgezeichnen. Erkennung, ob Backups liefen, wie groß diese Anwuchsen pro Tag, SNMP-Abfragen usw., ...

Auch hier bleibt die Devise "The sky is the limit".

Das war nun allerdings der letzte Teil dieser Blogbeitrag-Serie. Hoffentlich konnten wir Ihnen bei Ihrem Skript behilflich seien.

Anderesfalls kontaktieren Sie uns!

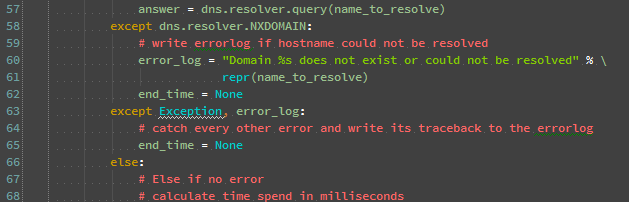

Willkommen zurück zu unserer Blog Serie über GeNiEnd2End Skripting!

Heute behandeln wir das Back-End Skripting und was dort beachtet werden sollte.

Was sind Back-End Skripte?

Back-End Skripte interagieren normalerweise nicht mit dem Desktop in irgendeiner Art.

Sie laufen im Hintergrund und behindern keinen an dem System arbeitenden Benutzer.

Es gibt keine Grenzen was gemessen werden kann, von Router Verbindungsstatistiken hin zu wie lange dauern SQL-Abfragen.

Was immer Sie messen wollen, Sie können es sich selber bauen.

Aber fangen Sie nicht einfach Hals über Kopf damit an, erfinden Sie das Rad nicht neu! Vielleicht gibt es bereits etwas da draußen, das Ihnen die Messwerte liefert, die Sie haben wollen.

Die AutoIt und Python Communities haben bereits viele Module / Libraries, die oft genau das tun / können was man möchte oder Ihnen dabei behilflich sein können, schneller an das Ziel zu kommen. Also schauen Sie zuerst in den Communities.

Wenn es bereits ein anderes Programm gibt, was Ihnen die Messwerte liefert die Sie gerne in GeNiEnd2End haben möchten, dann ist das gar kein Problem! Unsere AutoIt / Python Skripte benutzen manchmal auch im Betriebssystem enthaltene Tools (Ping, tracert, nslookup) oder andere herunterladbare Programme (z.B. PuTTY) um die Messwerte zu bekommen und diese Daten werden dann verarbeite, um nur die gewünschten Daten zu erhalten.

Sie müssen sich nur an die Regeln halten wie der GeNiAgent die Resultate bekommen möchte.

-

Schreiben Sie ein Log, vielleicht mit einer "Debug" Einstellung, das ein erweitertes Logging aktiviert wenn Sie es benötigen. Dieses kann sehr hilfreich sein, um schnell Probleme zu identifizieren, aufzuzeigen, wo es hängt bzw. welche Unterschiede es zwischen Programmierumgebung und der kompilierten Version gibt. Der GeNiAgent sucht ausserdem nach einem "error.log" und "detail.log" im Skript Ordner und lädt diese auf den GeNiEnd2End Server hoch. Diese sind dann direkt in der Weboberfläche einsehbar.

-

Wenn Sie ein Programm benutzen müssen was auf dem Desktop erscheint, sollten Sie es versteckt starten.In AutoIt ShellExecute gibt es eine Option namens showflag, diese kann auf "@SW_HIDE" gesetzt werden.In Python können Sie eine hidden flag an den Subprozess anhängen, siehe Hilfe für Informationen.

-

Seien Sie sich bewusst, das wenn ein Skript im Hintergrund über den GeNiAgenten gestartet wird, es andere Rechte haben kann als wenn Sie es manuell starten. Somit könnten andere Probleme auftreten. Normalerweise beeinflusst das die meisten Skripte nicht. Wenn Sie wirklich Admin Rechte benötigen, können Sie AutoIt anweisen, diese mit der "#RequireAdmin" Flag am Beginn des Skripts anzufragen - aber dann sollte der GeNiAgent ebenso mit administrativen Berechtigungen gestartet werden.

- Wenn Sie viele Transaktionen nacheinander durchführen oder Sie die Packet Trace / CNS Option benutzen, sollten Sie darauf achten, nach jeder Transaktion 5 Sekunden Pause einzuhalten bevor die nächste Transaktion gestartet wird.

- Wenn Sie ein externes Programm zum Erhalt von Messwerten nutzen, überprüfen Sie diese auf Plausibilität und wie sich der Messwert zusammensetzt.

Nun können Sie durch die GeNiEnd2End Hilfe-Sektion der Skripting Sprache gehen, die Sie benutzen wollen. Diese können Ihnen bei weiteren Vorgehensweisen helfen.

Im letzten Blogbeitrag dieser Serie zeigen wir Ihnen einige unserer Skripte und auch welche, die es inzwischen in die Standardskripte geschafft haben.

Willkommen zurück zu unserer Blog Serie über GeNiEnd2End Skripting!

Heute behandeln wir das GUI basierte Front-End Skripting und was dort beachtet werden sollte.

Skripte, die mit dem Desktop interagieren, sind einfacher in AutoIt zu erstellen, dadurch aber nur auf der Windows-Platform lauffähig.

Die Hardware des Roboters sollte der von normalen Benutzern entsprechen, ansonsten werden die Messergebnisse von denen der normalen Benutzer abweichen. Es sollte eine physikalische Hardware genommen werden und keine virtuelle Maschine. Schliesslich geht es darum, Probleme zu finden, die ein Benutzer haben könnte und Messwerte zu bekommen, wie lange eine Transaktion für einen Benutzer dauert.

Jede Messung, die wie ein Benutzer agieren soll, sollte mit einer Klickstrecke starten. Diese enthält alle Schritte die das Skript durchführen soll, und man setzt dort die Messpunkte bzw. kann sie dadurch herausfinden. Diese hilft später beim Auffinden von Problemursachen, wenn das Skript an einer spezifischen Stelle hängen bleibt.

Beispiel Klickstrecke von einem unserer Produktionsskripte:

![]() PDF Klickstrecken Dokumentation

PDF Klickstrecken Dokumentation

Best Practices

-

Schreiben Sie ein Log, vielleicht mit einer "Debug" Einstellung, das ein erweitertes Logging aktiviert wenn Sie es benötigen. Dieses kann sehr hilfreich sein, um schnell Probleme zu identifizieren, aufzuzeigen, wo es hängt bzw. welche Unterschiede es zwischen Programmierumgebung und der kompilierten Version gibt. Der GeNiAgent sucht ausserdem nach einem "error.log" und "detail.log" im Skript Ordner und lädt diese auf den GeNiEnd2End Server hoch. Diese sind dann direkt in der Weboberfläche einsehbar.

-

Hat die Applikation eine sich schnell verändernde Oberfläche (viele Änderungen am GUI)? Wenn das so ist, sollten Sie versuchen, Fenstertexte (Titel / Inhalt) für die Messungen zu nehmen, so dass Ihr Skript nicht so einfach von GUI-Änderungen beeinflusst wird.

-

Wenn Sie die Bildersuche (Image search) benutzen müssen:Dann sollten Sie versuchen, die Bildausschnitte so neutral wie möglich zu machen. Das heisst: Nehmen Sie Bildausschnitte von GUI-Elementen, die sich so wenig wie möglich verändern können oder einfach zu finden sind, auch wenn sich die Lokation etwas verändert hat. Die Größe des Bildausschnitts der gesucht wird, sollte so klein wie möglich sein. Dadurch ist die Chance höher, dass er auch nach Änderungen gefunden wird. Die Screenshots sollten auf einen Roboter erstellt werden, so das keine Farbunterschiede oder andere Eigenheiten vorhanden sind.

-

Wird die Applikation anzeigen, wenn etwas fehlschlägt - z.B. Fehlermeldungen \ Fehlerbehandlung?Sie sollten überprüfen, ob nach einer fehlgeschlagenen Messung Fehlermeldungen bestätigt werden müssen oder was passiert, wenn die Applikation sich nicht richtig geschlossen hat. Behalten Sie das im Hinterkopf und skripten Sie für diese Fälle. Schreiben Sie ein "error.log" und "detail.log".

-

Können Sie die Schritte nur mit Mausklicks vornehmen oder auch mit Tastaturkürzeln?Sie können Tastatureingaben senden, das ist meistens der bessere Weg, um mit dem Desktop zu interagieren. Dies gelingt natürlich nur, wenn es die selbe Funktion ist wie bei einem Mausklick.Wenn Sie einen Mausklick machen müssen und die Lokation des Klicks sich möglicherweise ändert, machen Sie eine Bildersuche (Image search). Dazu suchen Sie nach einem Stück des Buttons und klicken dann darauf, so das Sie nicht den falschen Button anklicken, weil er sich eventuell leicht bewegt hat.Wenn Ihre Applikation keine IDs / Namen der Designelemente vergibt, können Sie diese auch direkt ansprechen. (Überprüfen Sie das mit dem AutoIt Window Info Programm)

- Wenn Sie viele Transaktionen nacheinander durchführen oder Sie die Packet Trace / CNS Option benutzen, sollten Sie darauf achten, nach jeder Transaktion 5 Sekunden Pause einzuhalten bevor die nächste Transaktion gestartet wird.

Dieses Beispiel Skript läuft auf einem Roboter, es ist ein AutoIT Skript was mit dem IBM Notes Client 8.5 und 9.0 ohne größere Änderrungen agiert.

Nächstes Mal befassem Wir uns mit Back-End Skripting.

Willkommen zu dieser kurzen Blog Serie über ![]() GeNiEnd2End Application - HowTo / Best Practices Scripting!

GeNiEnd2End Application - HowTo / Best Practices Scripting!